인공지능 및 과학 컴퓨팅을 위한 InfiniBand

복잡한 워크로드에는 고해상도 시뮬레이션, 매우 큰 크기의 데이터세트 및 고도로 병렬화된 알고리즘의 초고속 처리가 필요합니다. 이러한 요구 사항이 계속 늘어나는 추세에서, 세계 유일의 완전 오프로드 가능한 인-네트워크 컴퓨팅 플랫폼인 NVIDIA Quantum InfiniBand는 성능을 극적으로 향상해 비용과 복잡성이 적으면서도 더 빠른 발견 시간을 달성합니다.

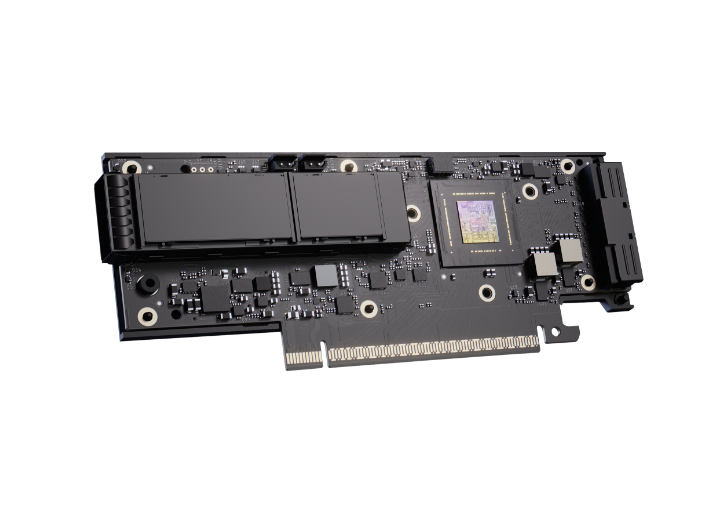

NVIDIA ConnectX InfiniBand 어댑터

최고의 슈퍼컴퓨터 및 클라우드 개선

보다 빠른 속도와 혁신적인 인-네트워크 컴퓨팅 활용하는 NVIDIA ConnectX InfiniBand 스마트 어댑터는 뛰어난 성능 및 확장성을 달성합니다. NVIDIA ConnectX는 작업당 비용을 낮춰 고성능 컴퓨팅(HPC), 머신 러닝, 고급 스토리지, 클러스터형 데이터베이스, 저지연 임베디드 I/O 애플리케이션 등의 ROI를 높입니다.

복잡한 워크로드에는 고해상도 시뮬레이션, 초대규모 데이터세트, 고도로 병렬화된 알고리즘의 초고속 처리가 필요합니다. 이러한 컴퓨팅 요구 사항이 계속 증가함에 따라, 세계 유일의 완전 오프로드형 인-네트워크 컴퓨팅 플랫폼인 NVIDIA Quantum InfiniBand는 비용과 복잡성이 적은 고성능 컴퓨팅(HPC), AI 및 하이퍼스케일 클라우드 인프라에서 최고의 성능을 달성하는 데 필요한 극적인 성능 향상을 가져다줍니다.

InfiniBand 강화 기능

-

네트워크 내 컴퓨팅

NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol(SHARP)™은 집단 통신 작업을 스위치 네트워크로 오프로드하여 네트워크를 통과하는 데이터의 양을 줄이고 MPI(메시지 전달 인터페이스) 작업 시간을 단축하며 데이터 센터 효율성을 높입니다.

-

자가 치유 네트워크

자가 치유 네트워크 기능을 갖춘 NVIDIA InfiniBand는 링크 장애를 극복하여 다른 소프트웨어 기반 솔루션보다 5,000배 빠른 네트워크 복구를 가능하게 합니다. 이러한 기능은 최신 세대의 InfiniBand 스위치에 내장된 인텔리전스를 활용합니다.

-

서비스 품질

InfiniBand는 고급 정체 제어 및 적응형 라우팅을 포함하여 입증된 서비스 품질 기능을 갖춘 유일한 고성능 상호 연결 솔루션으로, 탁월한 네트워크 효율성을 제공합니다.

-

네트워크 토폴로지

InfiniBand는 중앙 집중식 관리를 제공하고 Fat Tree, Hypercubes, 다차원 Torus 및 Dragonfly+를 포함한 모든 토폴로지를 지원합니다. 라우팅 알고리즘은 특정 애플리케이션 통신 패턴에 대한 토폴로지를 설계할 때 성능을 최적화합니다.

최적의 성능을 위한 소프트웨어

-

MLNX_OFED

OpenFabrics Alliance 의 OFED는 고성능 입출력(IO) 제조업체가 공동으로 개발하고 테스트했습니다. NVIDIA MLNX_ OFED는 NVIDIA에서 테스트한 OFED 버전입니다.

-

HPC-X®

NVIDIA HPC-X®는 포괄적인 MPI 및 SHMEM/PGAS 소프트웨어 제품군입니다. HPC-X는 InfiniBand 네트워크 내 컴퓨팅 및 가속 엔진을 활용하여 연구 및 산업 애플리케이션을 최적화합니다.

-

UFM®

NVIDIA Unified Fabric Manager (UFM®) 플랫폼은 데이터 센터 관리자가 InfiniBand 네트워크 인프라를 효율적으로 프로비저닝, 모니터링, 관리하고 사전에 문제를 해결할 수 있도록 지원합니다.

-

Magnum IO™

NVIDIA Magnum IO™는 네트워크 IO, 네트워크 내 컴퓨팅, 스토리지 및 IO 관리를 활용하여 다중 GPU, 다중 노드 시스템에 대한 데이터 이동, 액세스 및 관리를 단순화하고 속도를 높입니다.

고성능, 확장성, 보안을 갖춘

기가 스케일 AI 데이터센터를 위한 차세대 네트워킹

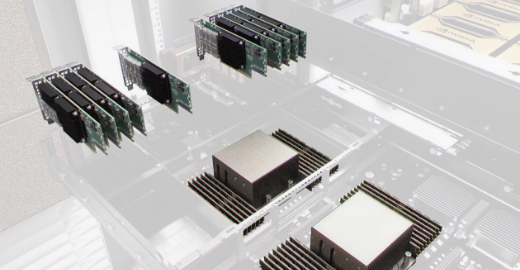

AI 데이터센터는 검색 증강 생성(RAG), 모델 훈련, 추론을 위해 가속화된 네트워크 성능을 필요로 합니다. NVIDIA 네트워킹은 오늘날의 AI 사용 사례에 필요한 최고 수준의 효율성과 최저 레이턴시의 데이터 전송을 보장합니다.

AI 및 클라우드를 위한 가속 Ethernet

클라우드 컴퓨팅, 데이터 스토리지, AI 등을 포함한 다양한 애플리케이션에서 업계 최고의 이더넷 성능, 가용성 및 사용 편의성을 경험해 보세요. NVIDIA Spectrum™ 이더넷은 Spectrum 스위치, NVIDIA® ConnectX® NIC, BlueField® DPU 및 SuperNIC, LinkX® 케이블, 네트워킹 소프트웨어 등을 포함하는 End-To-End 플랫폼입니다.

AI 및 과학 컴퓨팅을 위한 InfiniBand

복잡한 워크로드에는 고해상도 시뮬레이션, 매우 큰 크기의 데이터세트 및 고도로 병렬화된 알고리즘의 초고속 처리가 필요합니다. 이러한 요구 사항이 계속 늘어나는 추세에서, 세계 유일의 완전 오프로드 가능한 인-네트워크 컴퓨팅 플랫폼인 NVIDIA Quantum InfiniBand는 성능을 극적으로 향상해 비용과 복잡성이 적으면서도 더 빠른 발견 시간을 달성합니다.

Platform Full stack Provider 리더스시스템즈는

DGX System 기반 AI 데이터센터 통합 솔루션을 제공합니다.

회사소개 바로가기

-

NVIDIA Partner Network 인증 파트너

리더스시스템즈는 NVIDIA Elite Partner로서 Blackwell 및 Grace 기반 시스템 도입 경험을 바탕으로 소프트웨어 스택(NVIDIA AI Enterprise)과 시스템 튜닝을 고객의 워크로드에 맞춰 최적화합니다.

-

AI 인프라 구축·운영 토탈 서비스

설계부터 구축, 운영, 최적화까지 모든 단계를 직접 지원합니다. 고객의 비즈니스 확장 속도에 맞춘 모듈형 확장과 고가용성(HA) 설계로 장기 운영 신뢰성을 보장합니다.

-

운영 효율을 높이는 전문 기술 지원

구축 이후에도 모니터링, 정기 점검, 운영 교육을 지속적으로 지원하며, 이슈 발생 시 신속한 대응으로 다운타임을 최소화하고 데이터센터 TCO 최적화를 실현합니다.

-

글로벌 파트너십 기반 Full-Stack 공급

시스템 도입에 필요한 보안, 전력(UPS), 냉각 시스템, 네트워크 및 스토리지까지 검증된 글로벌 기업들과의 기술 협력을 통해 통합 솔루션을 제공합니다.

Product Specifications

| Supported network protocols | Ethernet, InfiniBand | InfiniBand speeds | 800/400/200/100 Gb/s |

|---|---|---|---|

| Maximum total bandwidth | 800Gb/s | Host interface | PCIe Gen6: up to 48 lanes |

| Ethernet speeds | 800/400/200/100/50/25 Gb/s | Portfolio |

|

Features*

| InfiniBand Interface |

|

|---|---|

| Host Interface |

|

| AI Networking |

|

| Cloud Networking |

|

| Security |

|

| Management and Control |

|

| Network Boot |

|

주문 정보 및 자세한 제품 사양은 [주]리더스시스템즈에 문의하세요.