제품문의

제품과 관련하여 궁금하신 사항을

문의하기를 통해 해결하세요.

복잡한 워크로드에는 고해상도 시뮬레이션, 극한 크기의 데이터 세트 및 고도로 병렬화된 알고리즘의 초고속 처리가 필요합니다. 이러한 컴퓨팅 요구 사항이 계속 증가함에 따라, 세계 유일의 완전 오프로드 가능한 네트워크 컴퓨팅 가속화 기술인 NVIDIA Quantum InfiniBand는 더 적은 비용과 복잡성으로 고성능 컴퓨팅(HPC), AI 및 하이퍼스케일 클라우드 인프라에서 타의 추종을 불허하는 결과를 달성하는 데 필요한 성능을 획기적으로 향상시킵니다.

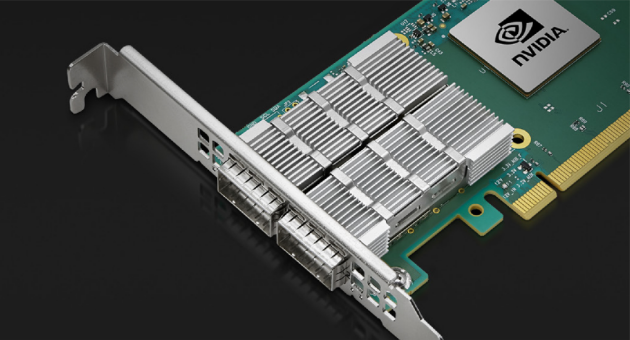

NVIDIA® ConnectX®-6 InfiniBand 스마트 어댑터 카드는 NVIDIA Quantum InfiniBand 플랫폼의 핵심 요소입니다. ConnectX-6은 성능과 확장성을 향상시키는 매우 낮은 지연 시간, 높은 메시지 전송률, 스마트 오프로드 및 NVIDIA In-Network Computing 가속화로 최대 2개의 포트 200Gb/s InfiniBand 및 이더넷 연결을 제공합니다.

보다 빠른 속도와 혁신적인 인-네트워크 컴퓨팅 활용하는 NVIDIA ConnectX InfiniBand 스마트 어댑터는 뛰어난 성능 및 확장성을 달성합니다. NVIDIA ConnectX는 작업당 비용을 낮춰 고성능 컴퓨팅(HPC), 머신 러닝, 고급 스토리지, 클러스터형 데이터베이스, 저지연 임베디드 I/O 애플리케이션 등의 ROI를 높입니다.

복잡한 워크로드에는 고해상도 시뮬레이션, 초대규모 데이터세트, 고도로 병렬화된 알고리즘의 초고속 처리가 필요합니다. 이러한 컴퓨팅 요구 사항이 계속 증가함에 따라, 세계 유일의 완전 오프로드형 인-네트워크 컴퓨팅 플랫폼인 NVIDIA Quantum InfiniBand는 비용과 복잡성이 적은 고성능 컴퓨팅(HPC), AI 및 하이퍼스케일 클라우드 인프라에서 최고의 성능을 달성하는 데 필요한 극적인 성능 향상을 가져다줍니다.

보다 빠른 속도와 혁신적인 인-네트워크 컴퓨팅 활용하는 NVIDIA ConnectX InfiniBand 스마트 어댑터는 뛰어난 성능 및 확장성을 달성합니다. NVIDIA ConnectX는 작업당 비용을 낮춰 고성능 컴퓨팅(HPC), 머신 러닝, 고급 스토리지, 클러스터형 데이터베이스, 저지연 임베디드 I/O 애플리케이션 등의 ROI를 높입니다.

ConnectX-6은 또한 NVIDIA Socket Direct 구성에 대한 옵션을 제공합니다. 이 옵션은 각 CPU가 전용 PCIe 인터페이스를 통해 네트워크에 액세스할 수 있도록 하여 멀티 socket 서버의 성능을 향상시킵니다.

NVIDIA In-Network Computing 및 In-Network Memory 기능을 통해 계산을 네트워크로 훨씬 더 분산하여 CPU 주기를 절약하고 네트워크 효율성을 높입니다. IBTA 사양에 정의된 원격 직접 메모리 액세스(RDMA) 기술을 활용하여 짧은 대기 시간과 고성능을 제공합니다.

로우 프로파일 스탠드업 PCIe와 QSFP 커넥터가 있는 OCP Gen 3.0 카드 두 가지 폼 팩터로 제공하며, 단일 포트, HDR, 스탠드업 PCIe 어댑터는 ConnectX-6 또는 ConnectX-6 DE(HPC 애플리케이션용으로 강화된 ConnectX-6 Dx)를 기반으로 제공됩니다. 또한 특정 PCIe 스탠드업 카드는 액체 냉각 Intel Server System D50TNP 플랫폼에 삽입하기 위한 콜드 플레이트와 함께 사용할 수 있습니다.

진화하는 NVMe-oF(NVMe-over Fabrics) 프로토콜은 RDMA 연결을 활용하여 원격으로 NVMe 스토리지 장치에 효율적으로 액세스하는 동시에 엔드 투 엔드 NVMe 모델의 대기 시간을 가장 낮게 유지합니다. NVMe-oF 대상 및 이니시에이터 오프로드를 통해 NVMe-oF를 더욱 최적화하여 CPU 활용률과 확장성을 향상시킵니다.

데이터 분석은 많은 엔터프라이즈 데이터 센터, 클라우드 및 하이퍼스케일 플랫폼 내에서 필수적인 기능이 되었습니다. 특히 머신 러닝(ML)은 높은 처리량과 짧은 대기 시간에 의존하여 심층 신경망을 훈련하고 인식 및 분류 정확도를 개선합니다. 200Gb/s의 처리량을 갖춘 ConnectX-6는 ML 애플리케이션에 필요한 수준의 성능과 확장성을 제공하는 훌륭한 솔루션입니다.

ConnectX-6 블록 수준 암호화는 네트워크 보안에 중요한 혁신을 제공합니다. 전송 중인 데이터는 저장되거나 검색될 때 암호화 및 암호 해독을 거칩니다. ConnectX-6 하드웨어는 CPU에서 IEEE AES-XTS 암호화/복호화를 오프로드하여 대기 시간과 CPU 사용률을 절약하고 전용 암호화 키를 사용하여 동일한 리소스를 공유하는 사용자를 보호합니다.

NVIDIA® ConnectX®-7 계열의 RDMA(Remote Direct Memory Access) 네트워크 어댑터는 InfiniBand 및 이더넷 프로토콜과 최대 400Gb/s의 다양한 속도를 지원합니다. 이를 통해 전통적인 기업의 요구사항을 해결하는 광범위한 스마트하고 확장 가능하며 기능이 풍부한 네트워킹 솔루션을 사용할 수 있으며, 이 솔루션은 세계에서 가장 까다로운 AI, 과학 컴퓨팅 및 하이퍼스케일 클라우드 데이터 센터 워크로드까지 지원합니다.

ConnectX-7은 조직이 IT 인프라를 현대화하고 보안할 수 있도록 지원하는 광범위한 소프트웨어 정의, 하드웨어 가속 네트워킹, 스토리지 및 보안 기능을 제공합니다. 또한 ConnectX-7은 엣지에서 핵심 데이터 센터, 클라우드에 이르기까지 민첩하고 고성능 솔루션을 제공하는 동시에 네트워크 보안을 강화하고 총 소유 비용을 절감합니다.

ConnectX-7은 초저지연, 최고의 처리량 및 혁신적인 NVIDIA In-Network Computing 엔진을 제공하여 오늘날의 현대 과학 컴퓨팅 워크로드에 필요한 가속화, 확장성 및 풍부한 기술을 제공합니다.

NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol(SHARP)™은 집단 통신 작업을 스위치 네트워크로 오프로드하여 네트워크를 통과하는 데이터의 양을 줄이고 MPI(메시지 전달 인터페이스) 작업 시간을 단축하며 데이터 센터 효율성을 높입니다.

자가 치유 네트워크 기능을 갖춘 NVIDIA InfiniBand는 링크 장애를 극복하여 다른 소프트웨어 기반 솔루션보다 5,000배 빠른 네트워크 복구를 가능하게 합니다. 이러한 기능은 최신 세대의 InfiniBand 스위치에 내장된 인텔리전스를 활용합니다.

InfiniBand는 고급 정체 제어 및 적응형 라우팅을 포함하여 입증된 서비스 품질 기능을 갖춘 유일한 고성능 상호 연결 솔루션으로 탁월한 네트워크 효율성을 제공합니다.

InfiniBand는 중앙 집중식 관리를 제공하고 Fat Tree, Hypercubes, 다차원 Torus 및 Dragonfly+를 포함한 모든 토폴로지를 지원합니다. 라우팅 알고리즘은 특정 애플리케이션 통신 패턴에 대한 토폴로지를 설계할 때 성능을 최적화합니다.

OpenFabrics Alliance의 OFED는 고성능 입출력(IO) 제조업체가 공동으로 개발하고 테스트했습니다. NVIDIA MLNX_OFED는 NVIDIA에서 테스트한 OFED 버전입니다.

NVIDIA HPC-X®는 포괄적인 MPI 및 SHMEM/PGAS 소프트웨어 제품군입니다. HPC-X는 InfiniBand 네트워크 내 컴퓨팅 및 가속 엔진을 활용하여 연구 및 산업 애플리케이션을 최적화합니다.

NVIDIA Unified Fabric Manager (UFM®) 플랫폼은 데이터 센터 관리자가 InfiniBand 네트워크 인프라를 효율적으로 프로비저닝, 모니터링, 관리하고 사전에 문제를 해결할 수 있도록 지원합니다.

NVIDIA Magnum IO™는 네트워크 IO, 네트워크 내 컴퓨팅, 스토리지 및 IO 관리를 활용하여 다중 GPU, 다중 노드 시스템에 대한 데이터 이동, 액세스 및 관리를 단순화하고 속도를 높입니다.

NVIDIA ® ConnectX ® -6 Lx 이더넷 스마트 네트워크 인터페이스 카드(SmartNIC)는 클라우드 및 기업에서 25GbE 배포를 위한 최고의 총 소유 비용으로 확장성, 고성능, 고급 보안 기능 및 가속화된 네트워킹을 제공합니다. 데이터 센터. SmartNIC는 PCI Express Gen3 및 Gen4 x8 호스트 연결과 함께 최대 2개의 25GbE 포트 또는 50GbE 연결의 단일 포트를 지원하여 타협 없는 데이터 센터에 최첨단 성능과 보안을 제공합니다.

Supports both 50G SerDes (PAM4)- and 25G SerDes (NRZ)-based ports

Industry-leading throughput, low CPU utilization, and high message rate

High performance and intelligent fabric for compute and storage infrastructures

Cutting-edge performance in virtualized networks, including network function virtualization (NFV)

Smart interconnect for x86, Power, Arm, GPU, and FPGA-based compute and storage platforms

| InfiniBand |

|

|---|---|

| Ethernet | - 200 / 100 / 50 / 40 / 25 / 10 / 1 GbE |

| Enhanced Features |

|

| CPU Offloads |

|

|

Hardware-Based I/O Virtualization NVIDIA ASAP2 |

|

| Storage Offloads |

|

| Overlay Networks |

|

| Management and Control |

|

주문 정보 및 자세한 제품 사양은 [주]리더스시스템즈에 문의하세요.

| PCI Express Interface |

|

|---|---|

| Operating Systems/Distributions |

|

| Connectivity |

|

| Ethernet Standards |

|

| SKU | OPN | Data Rate | Network Interface | Ports | PCIe | Technology | Crypto |

|---|---|---|---|---|---|---|---|

| 900-9X6AF-0018-MT0 | MCX653105A-HDAT-SP | 200GbE/HDR | QSFP56 | Single | PCIe 4.0 x16 | VPI | - |

| 900-9X6AF-0058-ST2 | MCX653106A-HDAT-SP | 200GbE/HDR | QSFP56 | Dual | PCIe 4.0 x16 | VPI | - |

| 900-9X6AF-0016-ST2 | MCX653105A-ECAT-SP | HDR100 EDR IB and 100GbE | QSFP56 | Single | PCIe3.0/4.0 x16 | VPI | - |

| 900-9X603-0016-DT0 | MCX653105A-EFAT | HDR100/EDR IB/100GbE | QSFP56 | Single | PCIe 3.0/4.0 x16 | VPI | - |

| 900-9X6AF-0056-MT0 | MCX653106A-ECAT-SP | HDR100 EDR IB and 100GbE | QSFP56 | Dual | PCIe3.0/4.0 x16 | VPI | - |

| 900-9X657-0058-SI2 | MCX653436A-HDAI | 200GbE/HDR | QSFP56 | Dual | PCIe 4.0 x16 | VPI | - |

| 900-9X6B4-0058-DT0 | MCX654106A-HCAT | 200GbE/HDR | QSFP56 | Dual | PCIe 3.0 x16 | VPI | - |

| 900-9X628-0016-ST0 | MCX651105A-EDAT | HDR100/EDR IB/100GbE | QSFP56 | Single | PCIe 4.0 x8 | VPI | - |

| 900-9X6AF-0018-SS0 | MCX653105A-HDAL | 200GbE/HDR | QSFP56 | Single | PCIe 4.0 x16 | VPI | - |

| 900-9X6AF-0058-SS0 | MCX653106A-HDAL | 200GbE/HDR | QSFP56 | Dual | PCIe 4.0 x16 | VPI | - |

| 900-9X0BC-001H-ST1 | MCX683105AN-HDAT | HDR | QSFP56 | Single | PCIe 4.0 x16 | InfiniBand | Disabled |

| 900-9X657-0018-MI0 | MCX653435M-HDAI | HDR/200GbE | QSFP56 | Single | PCIe4.0 x16 | VPI | - |

| 900-9X657-0058-SB0 | MCX653436A-HDAB | HDR/200GbE | QSFP56 | Dual | PCIe4.0 x16 | VPI | - |