제품문의

제품과 관련하여 궁금하신 사항을

문의하기를 통해 해결하세요.

매년 출하되는 3,000만 개의 데이터센터 서버 중 3분의 1이 소프트웨어 정의 데이터센터 스택을 실행하는 데 소비됩니다. 최신 데이터센터 워크로드로 인해 데이터 처리량은 기하급수적으로 증가하고 있으며, 이를 지원하기 위해서는 기업의 네트워크 인프라를 발전시켜야 합니다. InfiniBand 또는 이더넷 중 선택지를 제공하는 NVIDIA의 가속화 네트워킹 솔루션을 이용하면 기업은 모든 최신 워크로드에 걸쳐 배포 준비 개발을 구현할 수 있으며, AI 투자 수익을 극대화하는 가속 컴퓨팅의 새로운 시대에 발맞추는 스토리지 요건을 충족하는 인프라를 구축할 수 있습니다.

데이터에 대한 필요성이 증대함에 따라, 모든 데이터센터에 데이터 시각화와 격리 필수 보안 기능을 구현하는 복잡한 광역 네트워크 환경은 발전하고 있습니다. NVIDIA의 네트워킹 솔루션은 보안을 강화하며, 데이터센터 자동화 과정을 간소화하고, 네트워크에 완전한 가시성을 구현하는 것을 지원합니다.

하드웨어(스위치, NIC, 인터커넥트)에서 소프트웨어(OS, 관리, 펌웨어) 및 지원에 이르기까지, 당사의 광범위한 포트폴리오는 모든 네트워킹 요구 사항을 충족합니다. 네트워크 외에도 당사의 에코시스템은 다른 NVIDIA 제품뿐만 아니라 주요 파트너 및 OEM 제품과의 호환성을 보장합니다.

NVIDIA의 소프트웨어 정의 하드웨어 가속 제품은 InfiniBand 또는 RoCE로 응용 프로그램을 가속화하거나 DPU를 통해 주요 워크로드를 격리하는 등의 모든 작업 진행 시, 네트워크 관리가 아닌 애플리케이션에 컴퓨팅 및 스토리지 리소스를 온전히 집중할 수 있도록 합니다.

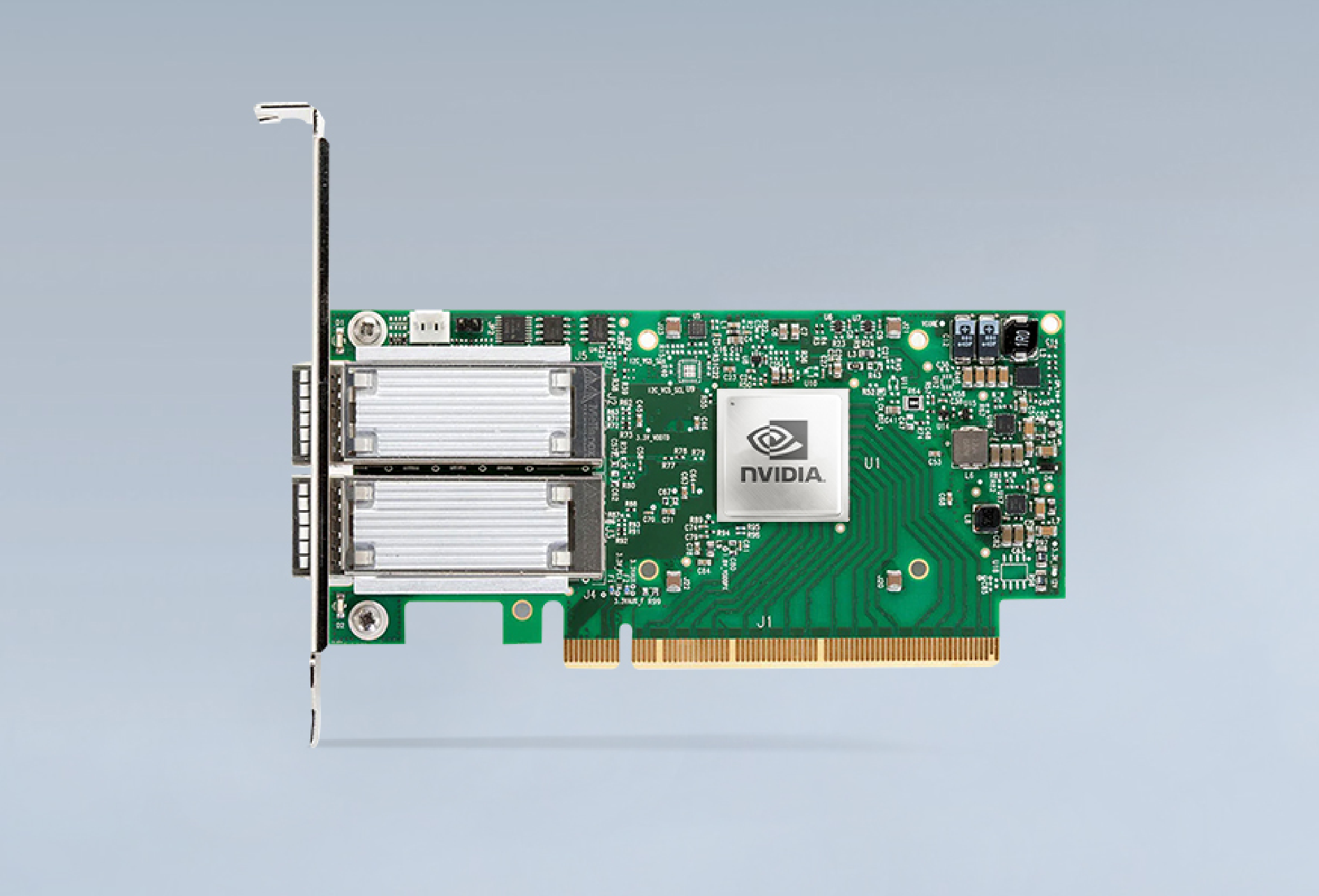

보다 빠른 속도와 혁신적인 인-네트워크 컴퓨팅 활용하는 NVIDIA ConnectX InfiniBand 스마트 어댑터는 뛰어난 성능 및 확장성을 달성합니다. NVIDIA ConnectX는 작업당 비용을 낮춰 고성능 컴퓨팅(HPC), 머신 러닝, 고급 스토리지, 클러스터형 데이터베이스, 저지연 임베디드 I/O 애플리케이션 등의 ROI를 높입니다.

네트워킹 기술에 관심이 있다면 개발자 커뮤니티에 가입해 보세요.

무료 SDK, 기술 문서, 동료 개발자와 도메인 전문가의 지원, 데이터센터 네트워킹 난제를 해결하는 데

적합한 하드웨어 정보를 얻을 수 있습니다. 경력이 풍부한 연구원, 신입 개발자,

독립 소프트웨어 공급업체(ISV), 클라우드 서비스 공급업체 모두에게 열려 있는 공간입니다.

NVIDIA® DOCA™는 NVIDIA BlueField® 데이터 처리 장치가 데이터센터 워크로드를 오프로드, 가속화 및 격리할 수 있는 가능성을 여는 열쇠입니다. DOCA를 통해 개발자는 제로 트러스트 보호 기능이 있는 소프트웨어 정의 클라우드 네이티브 DPU 가속 서비스를 만들어 현대 데이터센터의 증가하는 성능 및 보안 요구 사항을 해결함으로써 미래의 데이터센터 인프라를 프로그래밍할 수 있습니다.

NVIDIA MAGNUM IO™ 소프트웨어 개발 키트(SDK)를 통해 개발자는 AI, HPC(고성능 컴퓨팅), 데이터 과학 및 시각화 애플리케이션에서 입출력(IO) 병목 현상을 제거하여 워크플로의 종단 간 시간을 단축할 수 있습니다. Magnum IO는 가상화, 컨테이너화 및 베어메탈 환경에서 CPU, GPUsns, DPU 및 스토리지 하위 시스템 간의 데이터 이동의 모든 측면을 다룹니다.

NVIDIA Morpheus는 사이버 보안 개발자가 대량의 실시간 데이터를 필터링, 처리 및 분류하기 위해 최적화된 AI 파이프라인을 생성할 수 있도록 하는 개방형 애플리케이션 프레임워크입니다. AWS의 개발자 키트, Red Hat 또는 NVIDIA 인증 서버에서 실행되는 개발자 키트는 사전 훈련된 AI 모델을 지원하므로 고객이 대규모로 네트워크 및 서버 원격 측정을 지속적으로 검사할 수 있습니다.

100GbE 연결, 750ns 지연 시간, 초당 최대 2억 개의 메시지(Mpps) 및 Open Source Data Path Development Kit(DPDK) 4(PCDK)를 실행할 때 197Mpps의 기록적인 설정을 갖춘 고성능 유연한 솔루션을 제공합니다. 스토리지 워크로드의 경우 ConnectX-5는 하드웨어의 시그니처 핸드오버(T10-DIF), 내장 PCIe 스위치, 패브릭을 통한 NVMe 대상 오프로드 등 다양한 혁신적인 가속 성능을 제공합니다.

| PCI Express Interface |

|

||

|

Operating Systems/Distributions* |

|

||

| Connectivity |

|

(*) 이 표시 에서는 하드웨어의 특징 및 기능에 대해 설명합니다. 기능 가용성은 드라이버 및 펌웨어 릴리스 정보를 참조하십시오.

| InfiniBand |

|

||

| Enhanced Features |

|

||

| CPU Offloads |

|

||

|

Hardware-Based I/O Virtualization - Mellanox ASAP2 |

|

||

| Storage Offloads |

|

||

| Overlay Networks |

|

||

| Management and Control |

|

||

| Remote Boot |

|

(*) 이 표시 에서는 하드웨어의 특징 및 기능에 대해 설명합니다. 기능 가용성은 드라이버 및 펌웨어 릴리스 정보를 참조하십시오.

| OPN | InfiniBand Supported Speeds (Gb/s) | Network Ports | PCI Express Configuration |

Additional Features |

Cages |

|---|---|---|---|---|---|

| MCX555A-ECAT | FDR/EDR IB (100Gb/s) and 40/50/100GbE | 1 | PCIe3.0 x16 | QSFP28 | |

| MCX556A-ECAT | FDR/EDR IB (100Gb/s) and 40/50/100GbE | 2 | PCIe3.0 x16 | ||

| MCX556A-ECUT | FDR/EDR IB (100Gb/s) and 40/50/100GbE | 2 | PCIe3.0 x16 | UEFI enabled | |

| MCX556A-EDAT | FDR/EDR IB (100Gb/s) and 40/50/100GbE | 2 | PCIe4.0 x16 | ConnectX®-5 Ex VPI |