제품문의

제품과 관련하여 궁금하신 사항을

문의하기를 통해 해결하세요.

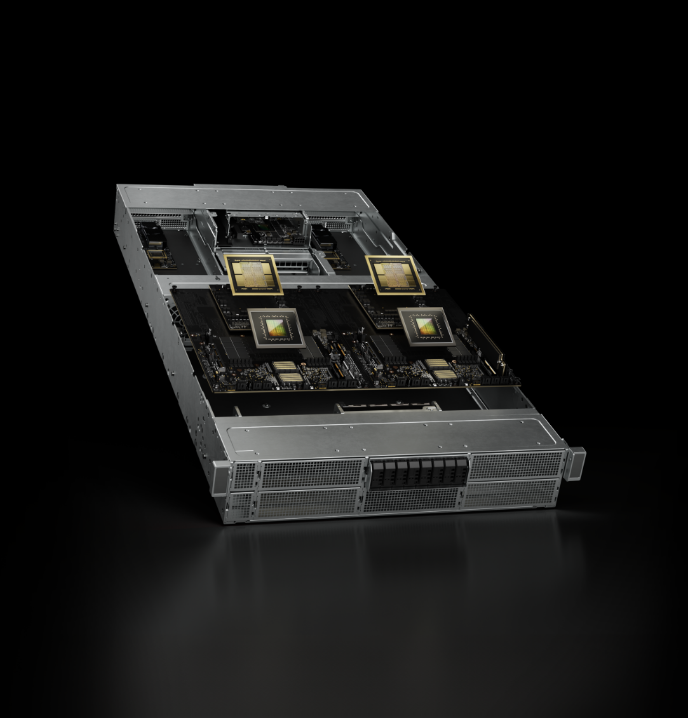

Configuration 2x Grace CPUs, 2x Blackwell GPUs

FP4 Tensor Core 40 PFLOPS

FP8/FP6 Tensor Core 20 PFLOPS

INT8 Tensor Core 20 POPS

FP16/BF16 Tensor Core 10 PFLOPS

TF32 Tensor Core 5 PFLOPS

FP32 180 TFLOPS

FP64/FP64 Tensor Core 90 TFLOPS

딥 러닝 워크스테이션 솔루션을 통해 작업 공간에서 편리하게 AI 슈퍼 컴퓨팅 성능을 활용하고 NGC에서 필요한 모든 딥 러닝 소프트웨어를 사용할 수 있습니다. 이제 딥 러닝을 필요로 하는 누구든지 데스크 사이드 딥 러닝을 시작할 수 있습니다.

모든 엔터프라이즈에서 물리적 데이터센터를 구축할 필요 없이 손쉽게 대규모 컴퓨팅 성능에 액세스할 수 있습니다. AI, 고성능 컴퓨팅(HPC) 및 의료 영상 활용, 차세대 그래픽 기술 적용 등 워크로드 전반에서 최고 성능을 경험할 수 있습니다.

GPU 가속 데이터센터는 원하는 규모와 더 적은 수의 서버로 컴퓨팅 및 그래픽 워크로드에 혁신적인 성능을 제공하여 더 빠르게 정보를 얻고 비용을 획기적으로 절감할 수 있습니다. 가장 복잡한 딥 러닝 모델을 트레이닝하여 가장 심각한 문제를 해결하세요.

현대 기업은 이제 수 십억 개의 IoT 센서를 통해 생성 된 데이터를 활용해 더 빠른 통찰력과 시간과 비용 절감을 할 수 있습니다. 실시간으로 결정을 내리고 강력하고 분산 된 컴퓨팅과 안전하고 간단한 원격 관리 및 업계 최고 기술과의 호환성을 기대할 수 있습니다.

원격 시각화부터 엣지에서의 슈퍼컴퓨팅까지 다양한 사용 사례에 사용할 수 있는 모듈형 참조 디자인인 NVIDIA MGX™를 통해 모든 컴퓨팅 요구 사항에 적응하세요. MGX는 ROI를 개선하고 출시 기간을 단축하여 모듈식 서버 설계에 대한 새로운 표준을 제공합니다. MGX를 통해 OEM 및 ODM 파트너는 다양한 사용 사례에 맞는 맞춤형 솔루션을 구축하는 동시에 개발 리소스를 절약하고 출시 시간을 단축할 수 있습니다. 모듈식 참조 아키텍처를 사용하면 NVIDIA Grace™ , x86 또는 기타 Arm® CPU 서버와 NVIDIA OVX™ 시스템을 포함하여 GPU, CPU 및 DPU의 다양한 구성을 허용하여 다양한 엔터프라이즈 데이터 센터 워크로드를 가속화할 수 있습니다.

모든 데이터센터에 새로운 컴퓨팅 시대를 열어주는 NVIDIA GB200 Grace™ Blackwell NVL2 플랫폼은 2개의 Blackwell GPU와 2개의 Grace GPU를 통해 메인스트림 LLM(대규모 언어 모델) 추론, 벡터 데이터베이스 검색, 그리고 데이터 처리를 위한 탁월한 성능을 제공합니다. 스케일아웃 단일 노드 NVIDIA MGX™ 아키텍처로 설계되어 다양한 시스템 설계 및 네트워킹 옵션을 통해 가속 컴퓨팅을 기존 데이터센터 인프라에 원활하게 통합할 수 있습니다.

GB200 NVL2는 2개의 Grace CPU와 2개의 Blackwell GPU 간에 공유되는 최대 1.3테라바이트(TB)의 대규모 코히어런트 메모리를 제공합니다. 이 공유 메모리는 5세대 NVIDIA® NVLink™ 및 고속 칩 투 칩(C2C) 연결과 결합되어 Llama 3 70B와 같은 주류 언어 모델에 5배 더 빠른 실시간 LLM 추론 성능을 제공합니다.

GB200 NLV2는 RAG 벡터 검색 작업을 최대 9배까지 가속화합니다. Wikipedia 데이터 세트의 벡터 데이터베이스는 200기가바이트(GB)가 넘으며, Grace CPU의 960GB 메모리와 900GB/s 고속 C2C 링크에 대한 액세스는 레이턴시가 짧은 벡터 검색을 강화시킵니다.

데이터베이스는 엔터프라이즈에서 대량의 데이터를 취급, 처리, 분석하는 데 중요한 역할을 합니다. GB200 NVL2는 NVIDIA Blackwell 아키텍처의 고대역폭 메모리 성능 NVLink-C2C 및 전용 압축 해제 엔진을 활용하여 CPU에 비해 주요 데이터베이스 쿼리 속도를 18배 높입니다.

데이터 사이언스와 AI를 발전시키려면 조직은 클라우드 및 데이터센터에서 엣지에 이르는 GPU 기반 시스템을 최적화할 수 있는 도구를 이용해야 합니다.

NVIDIA의 소프트웨어 솔루션은 모든 최신 워크로드를 포괄하므로 IT 관리자, 데이터 사이언티스트, DevOps 팀과 개발자가 필요한 것을 빠르고 쉽게 이용할 수 있습니다.

모든 조직에서 AI를 사용할 수 있도록 최적화된 엔드 투 엔드 클라우드 기반 AI 및 데이터 분석 소프트웨어 제품군입니다. 엔터프라이즈 데이터센터에서 퍼블릭 클라우드에 이르기까지 어디에서나 배포할 수 있도록 인증받았고, AI 프로젝트를 순조롭게 진행하기 위한 글로벌 엔터프라이즈 지원이 포함됩니다.

CUDA-X AI는 딥 러닝, 머신 러닝 및 HPC(고성능 컴퓨팅)를 위한 필수 최적화를 제공하는 NVIDIA의 획기적인 병렬 프로그래밍 모델인 CUDA® 위에 구축된 소프트웨어 가속화 라이브러리 컬렉션입니다. cuDNN, cuML, NVIDIA® TensorRT™, cuDF, cuGraph 및 13개 이상의 기타 라이브러리가 포함됩니다.

NVIDIA Magnum IO™는 병렬의 비동기식 지능형 데이터센터 IO를 위한 아키텍쳐로, 멀티 GPU, 멀티 노드 가속화를 위해 스토리지 및 네트워크 IO 성능을 극대화합니다. 스토리지 IO, 네트워크 IO, 인-네트워크 컴퓨팅 및 IO 관리를 활용하여 멀티 GPU, 멀티 노드 시스템을 위한 데이터 이동, 액세스 및 관리를 단순화하고 가속화합니다.

NVIDIA Fleet Command™를 통해 엣지에서 시스템과 AI 애플리케이션의 프로비저닝 및 배포를 간소화하세요. 컨테이너 오케스트레이션을 위한 관리형 플랫폼으로 클라우드의 확장성과 복원력을 갖춘 분산 컴퓨팅 환경의 관리를 단순화하여 모든 사이트를 안전한 지능형 위치로 전환합니다.

NVIDIA® Riva는 완전히 사용자 정의 가능한 실시간 대화형 AI 파이프라인을 구축하기 위한 GPU 가속 다국어 음성 및 번역 마이크로서비스 세트입니다. Riva에는 자동 음성 인식(ASR), 텍스트 음성 변환(TTS), 신경 기계 번역(NMT)이 포함되며 모든 장치에 배포할 수 있습니다. LLM(대형 언어 모델) 및 RAG(검색 증강 생성)를 활용하세요.

엣지, 데이터 센터, 멀티 및 하이브리드 클라우드 환경에서 이기종 AI 및 고성능 컴퓨팅(HPC) 클러스터에 대한 빠른 배포와 엔드투엔드 관리를 제공합니다. 몇 개의 노드에서 수십만 개의 노드에 이르는 클러스터의 프로비저닝 및 관리를 자동화하고, NVIDIA GPU 가속 및 기타 시스템을 지원하며, Kubernetes와의 오케스트레이션을 활성화합니다.

NVIDIA NGC™는 엔터프라이즈 서비스, 소프트웨어, 관리 도구, 엔드 투 엔드 AI 및 디지털 트윈 워크플로우 지원을 위한 포털입니다. 완전 관리형 서비스를 통해 솔루션을 더 빠르게 출시하거나, 성능 최적화된 소프트웨어를 활용하여 선호하는 클라우드, 온프레미스, 엣지 시스템에서 솔루션을 구축하고 배포할 수 있습니다.

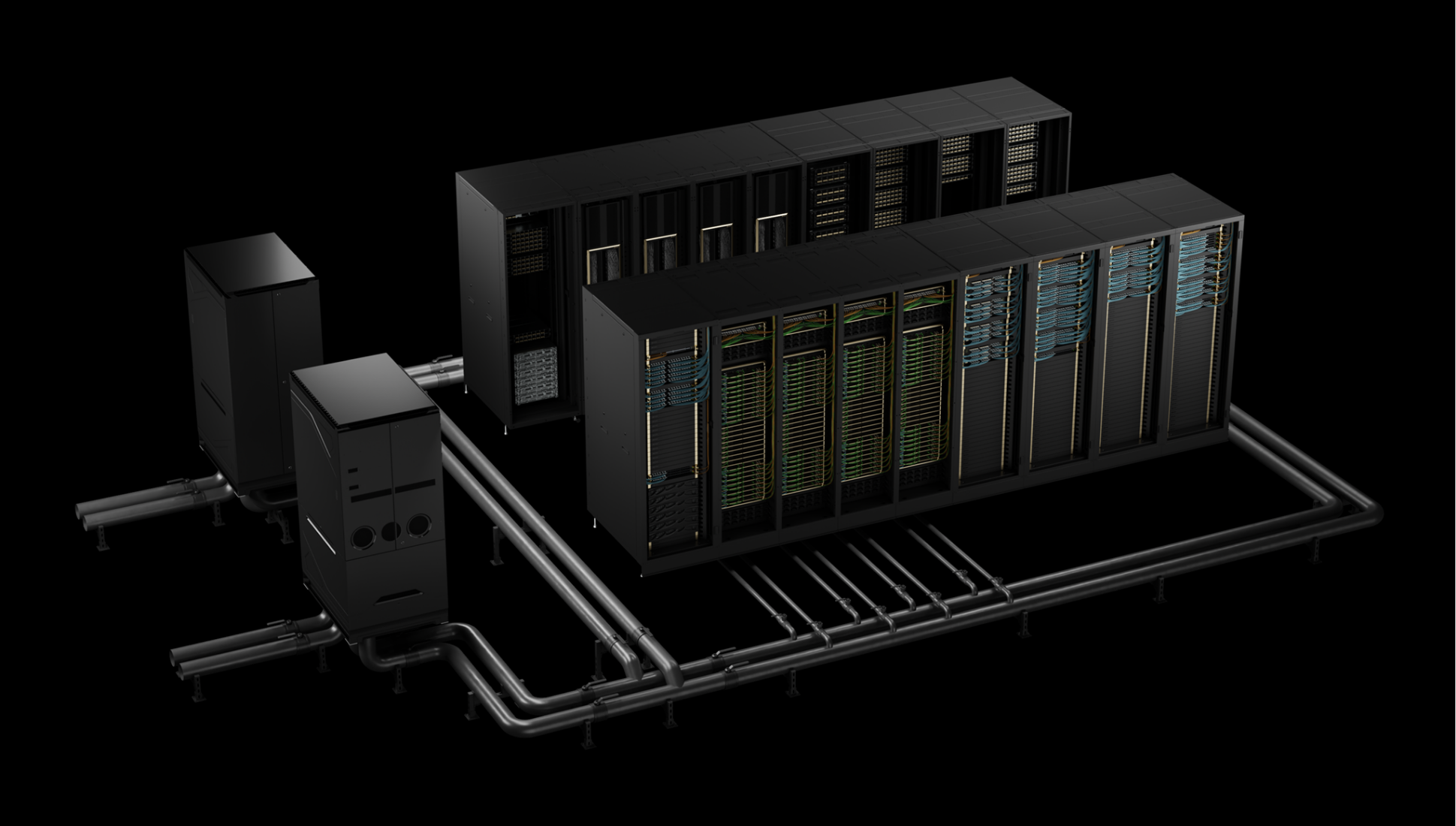

NVIDIA GB200 NVL72는 랙 규모 디자인으로 36개의 GB200 슈퍼칩을 연결합니다. GB200 NVL72는 단일 대규모 GPU 역할을 하는 72GPU NVLink 도메인을 자랑하는 수랭식 랙 규모의 솔루션입니다.

더 알아보기

| Configuration | 2× Grace CPUs, 2× Blackwell GPUs |

| FP4 Tensor Core | 40 PFLOPS |

| FP8/FP6 Tensor Core | 20 PFLOPS |

| INT8 Tensor Core | 20 POPS |

| FP16/BF16 Tensor Core | 10 PFLOPS |

| TF32 Tensor Core | 5 PFLOPS |

| FP32 | 180 TFLOPS |

| FP64/FP64 Tensor Core | 90 TFLOPS |

| GPU Memory / Bandwidth | Up to 384GB / 16TB/s |

| CPU Core Count | 144 Arm® Neoverse V2 cores |

| LPDDR5X Memory / Bandwidth | Up to 960GB / Up to 1,024GB/s |

| Interconnect |

|

| Server Options | Various NVIDIA GB200 NVL2 configuration options using NVIDIA MGX |

| 상품명 | NVIDIA GB200 NVL2 엔비디아코리아 정품 |

|---|---|

| KC 인증번호 | - |

| 정격전압 / 최대소비전력 | - |

| 정품 품질 보증 | 3년 무상보증 |

| 출시년월 | 2024 |

| 제조국 | - |

| 크기 | - |