고급 하드웨어 오프로드 및 가속화를 제공하는

업계 최고의 NVIDIA® ConnectX®

스마트 네트워크 인터페이스 카드(SmartNIC)

- 소프트웨어 정의

네트워킹 가속화 - ConnectX SmartNIC에 내장된 NVIDIA ASAP 기술은 CPU 패널티 없이 소프트웨어 정의 네트워킹을 가속화합니다.

- 엣지에서 코어까지

보안 제공 - ConnectX SmartNIC는 인라인 암호화 / 복호화로 보안을 오프로드하고 가속화하는 혁신적인 하드웨어 엔진을 제공합니다.

- 스토리지 성능 향상

- ConnectX SmartNIC는 RoCE 및 GPUDirect ® 스토리지를 통해 고성능 스토리지 및 데이터 액세스를 지원 합니다. NVM Express (NVMe) 및 전송 제어 프로토콜 (TCP) 가속이 ConnectX-7에 추가되었습니다.

- 정밀 타이밍 활성화

- ConnectX-6 Dx부터 ConnectX SmartNIC는 데이터 센터 애플리케이션 및 기본 인프라에 대해 정확한 시간 동기화 서비스를 제공합니다.

세계적 수준의 이더넷 성능

NVIDIA ASAP - 가속 스위치 및 패킷 처리® 기술, ConnectX SmartNIC는 네트워크 성능을 가속화하는 동시에 IP(Internet Protocol) 패킷 전송의 CPU 오버헤드를 줄여 애플리케이션을 실행하는데 더 많은 프로세서 주기를 확보할 수 있습니다.

최고의 RoCE(Converged Ethernet) 성능을 갖춘 ConnectX SmartNIC는 대역폭 및 지연 시간에 민감한 애플리케이션에 효율적인 고성능 RDMA(Remote Direct-Memory Access) 서비스를 제공합니다.

ConnectX SmartNIC는 최대 400Gb/s의 속도로 암호화/암호 해독을 오프로드하고 가속화합니다. 업계 최고의 DPDK(Data Plane Development Kit) 성능을 통해 CPU 주기를 줄이면서 더 많은 처리량을 제공합니다.

ConnectX SmartNIC는 하드웨어 내 신뢰 루트를 사용하여 운영 체제를 안전하게 부팅할 수 있습니다. ConnectX SmartNICS는 상위 가상화 및 컨테이너화 플랫폼뿐만 아니라 모든 주요 운영 체제에서 인증을 받았습니다.

이더넷 강화 기능

- DOCA SDK

- NVIDIA DOCA ™ 소프트웨어 개발 키트를 사용하면 개발자가 업계 표준 API를 활용하여 NVIDIA BlueField DPU 위에 애플리케이션과 서비스를 신속하게 만들 수 있습니다.

- 고급 보안

- 플랫폼 보안에서 가속화 된 암호화 및 분산 방화벽에 이르기까지 NVIDIA SmartNIC 및 DPU는 스택의 모든 계층에서 제로 트러스트 보호를 위해 소프트웨어 정의 하드웨어 가속화 보안 엔진을 제공합니다.

- 업계 최고의 RoCE

- NVIDIA SmarNIC 및 DPU는 동급 최고의 엔터프라이즈 급 RoCE (RDMA over Converged Ethernet) 가속화를 제공하여 확장형 분산 애플리케이션을 위한 탁월한 처리량과 짧은 지연 시간 연결을 제공합니다.

- SDN 가속

- NVIDIA Accelerated Switch and Packet Processing ® (ASAP2) 기술은 소프트웨어 정의 네트워크 성능을 가속화하는 동시에 비즈니스 워크로드를 위해 데이터 센터 CPU를 확보합니다.

- 데이터 센터를위한 가장 빠르고

효율적인 이더넷 달성 - 업계 최고의 ConnectX 지능형 네트워크 어댑터 제품군은 가장 광범위하고 가장 진보된 하드웨어 가속 엔진을 제공합니다. 규모에 관계없이 모든 워크로드를 실행하는 ConnectX는 클라우드 데이터 센터, 엔터프라이즈 환경, 통신 회사를 위한 SDN 및 네트워크 기능 가상화 (NFV)에 대해 최고의 ROI와 최저 TCO를 지원합니다.

PARTNERS

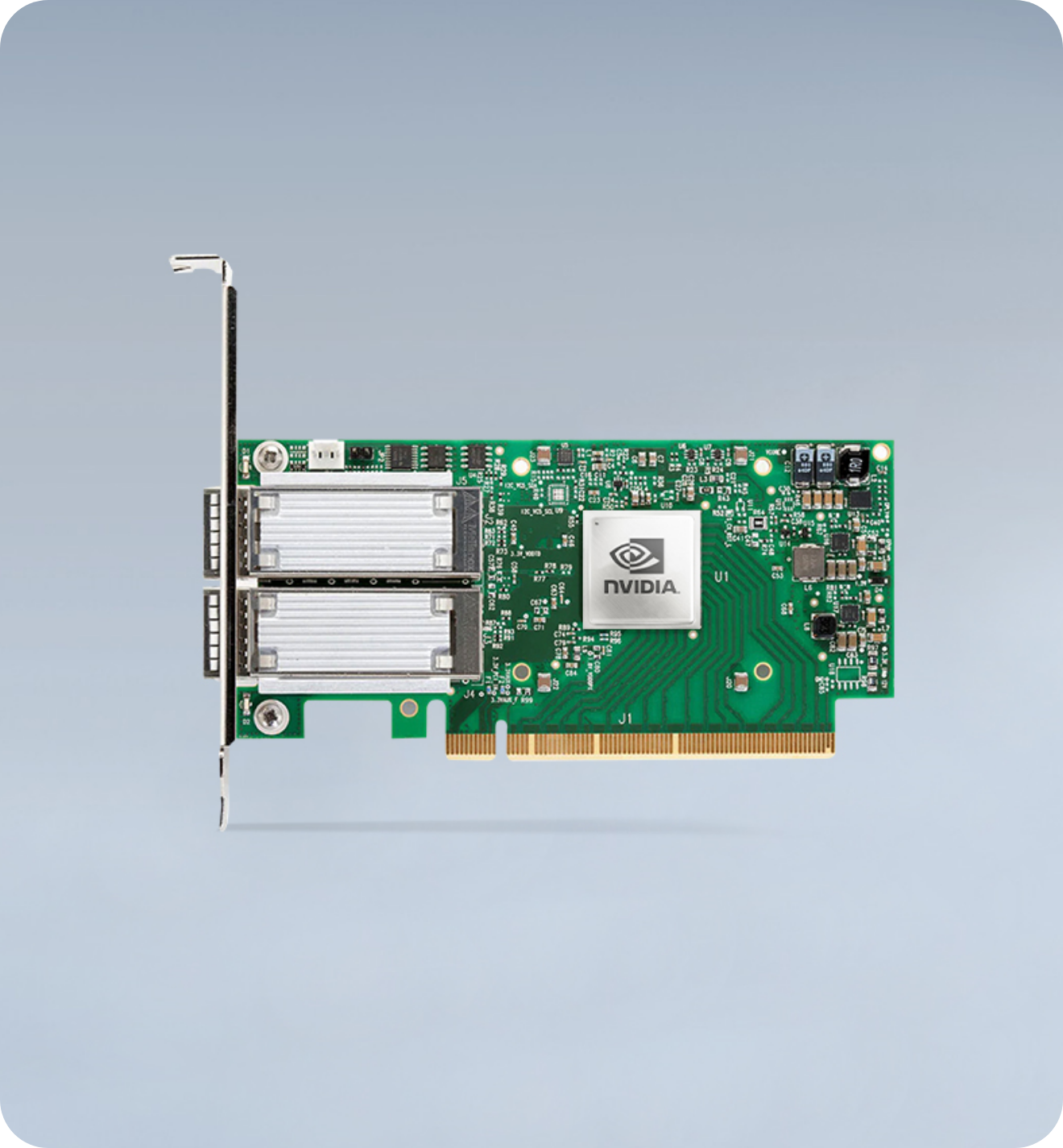

최고의 성능과 가장 유연한 솔루션 CONNECTX-5

Intelligent ConnectX-5 이더넷 어댑터 카드는 웹 2.0, 클라우드, 데이터 분석, 고성능 및 스토리지

플랫폼의 성능을 최적화하는 가속 엔진을 제공합니다.

ConnectX-5는 100 Gb/s 이더넷 연결 포트 2개,

매우 높은 메시지 속도, 내장형 PCIe 스위치 및 NVMe-oF (NVMe over Fabrics) 오프로드를 지원하여

다양한 애플리케이션 및 시장에 고성능 및 비용 효율적인 솔루션을 제공합니다.

- RoCE

-

NVIDIA RoCE 기술은 이더넷을 통한 패킷 전송을 캡슐화하고

CPU 로드를 줄여 네트워킹 및 스토리지 집약적인 애플리케이션을 위한

높은 대역폭과 짧은 대기 시간 네트워크 인프라를 지원합니다.

- ASAP²

- 획기적인 NVIDIA ASAP² 기술은 호스트의 CPU에서 어댑터로 Open vSwitch 데이터 경로를 오프로드함으로써 혁신적인 SR-IOV 및 VirtIO 가속화를 제공하여 최고의 성능과 확장성을 제공합니다.

- SR-IOV

- ConnectX 어댑터는 SR-IOV를 활용하여 가상화 환경의 물리적 리소스 및 기능에 대한 액세스를 분리합니다. 따라서 I/O 오버헤드가 줄어들고 어댑터는 거의 가상화되지 않은 성능을 유지할 수 있습니다.

HIGHLIGHTS

- PORT SPEEDS

- 200Gb/s

- MESSAGE RATE (DPDK)

- 148 million msgs/sec

- PCIe LANES

- x16 Gen2/Gen3

- ENCRYPTION

- N/A

NVIDIA Mellanox

ConnectX-5 EN Adapter Card 100GbE

Dual-Port QSFP28 PCIe 3.0 x16

Tall Bracket ROHS R6

ConnectX-5 MCX516A-CCAT 이더넷 네트워크 인터페이스 카드는 100GbE 연결, 750ns 지연 시간, 초당 최대 2억 개의 메시지(Mpps) 및 Open Source Data Path Development Kit (DPDK) 4(PCDK 0)를 실행할 때 197Mpps의 기록적인 포트가 있는 고성능 유연한 솔루션을 제공합니다. 스토리지 워크로드의 경우 ConnectX-5는 하드웨어의 시그니처 핸드오버(T10-DIF), 내장 PCIe 스위치, 패브릭을 통한 NVMe 대상 오프로드 등 다양한 혁신적인 가속 성능을 제공합니다.

- • 포트 당 최대 100 Gb/s 연결

- • 업계 최고의 처리량, 낮은 대기 시간, 낮은 CPU 사용률 및 높은 메시지 속도

- • 호스트 체인 기술을 기반으로 한 스토리지 및 머신 러닝을위한 혁신적인 랙 설계

- • x86, Power, Arm, GPU 기반 컴퓨팅 및 스토리지 플랫폼을위한 스마트 상호 연결

- • NVMe over Fabric 오프로드를 포함한 고급 스토리지 기능

- • 유연한 파이프 라인 프로그래밍 기능을 지원하는 지능형 네트워크 어댑터

- • NFV (Network Function Virtualization)를 포함한 가상화 된 네트워크의 최첨단 성능

- • 효율적인 서비스 체인 기능을위한 Enabler

- • 효율적인 I / O 통합, 데이터 센터 비용 및 복잡성 감소

Compatibility

PCI Express Interface

- PCIe Gen 4.0, 3.0, 2.0, 1.1 compatible

- 2.5, 5.0, 8.0, 16.0 GT/s link rate

- Auto-negotiates to x16, x8, x4, x2, or x1 lane(s)

- PCIe Atomic

- TLP (Transaction Layer Packet) Processing Hints (TPH)

- Embedded PCIe Switch: Up to 8 bifurcations

- PCIe switch Downstream Port Containment (DPC) enablement for PCIe hot-plug

- Access Control Service (ACS) for peer-to-peer secure communication

- Advance Error Reporting (AER)

- Process Address Space ID (PASID) Address Translation Services (ATS)

- IBM CAPI v2 support (Coherent Accelerator Processor Interface)

- Support for MSI/MSI-X mechanisms

Operating Systems/Distributions*

- RHEL/CentOS

- Windows

- FreeBSD

- VMware

- OpenFabrics Enterprise Distribution (OFED)

- OpenFabrics Windows Distribution (WinOF-2)

Connectivity

- Interoperability with Ethernet switches (up to 100GbE)

- Passive copper cable with ESD protection

- Powered connectors for optical and active cable support

(*) 이 표시 에서는 하드웨어의 특징 및 기능에 대해 설명합니다. 기능 가용성은 드라이버 및 펌웨어 릴리스 정보를 참조하십시오.

Features*

Ethernet

- Jumbo frame support (9.6KB)

Enhanced Features

- Hardware-based reliable transport

- Collective operations offloads

- Vector collective operations offloads

- Mellanox PeerDirect® RDMA (aka GPUDirect®) communication acceleration

- 64/66 encoding

- Extended Reliable Connected transport (XRC)

- Dynamically Connected Transport (DCT)

- Enhanced Atomic operations

- Advanced memory mapping support, allowing user mode registration and remapping of memory (UMR)

- On demand paging (ODP)

- MPI Tag Matching

- Rendezvous protocol offload

- Out-of-order RDMA supporting Adaptive Routing

- Burst buffer offload

- In-Network Memory registration-free RDMA memory access

CPU Offloads

- RDMA over Converged Ethernet (RoCE)

- TCP/UDP/IP stateless offload

- LSO, LRO, checksum offload

- RSS (also on encapsulated packet), TSS, HDS, VLAN and MPLS tag insertion/stripping, Receive flow steering

- Data Plane Development Kit (DPDK) for kernel bypass applications

-

Open VSwitch (OVS) offload using ASAP2

- Flexible match-action flow tables

- Tunneling encapsulation/ de-capsulation

- Intelligent interrupt coalescence

- Header rewrite supporting hardware offload of NAT router

Hardware-Based I/O Virtualization - Mellanox ASAP²

- Single Root IOV

- Address translation and protection

-

VMware NetQueue supporting

- SR-IOV: Up to 512 Virtual Functions

- SR-IOV: Up to 8 Physical Functions per host

-

Virtualization hierarchies (e.g., NPAR when enabled)

- Virtualizing Physical Functions on a physical port

- SR-IOV on every Physical Function

- Configurable and user-programmable QoS

- Guaranteed QoS for VMs

Storage Offloads

- NVMe over Fabric offloads for target machine

- T10 DIF - Signature handover operation at wire speed, for ingress and egress traffic

- Storage Protocols: SRP, iSER, NFS RDMA, SMB Direct, NVMe-oF

Overlay Networks

- RoCE over overlay networks

- Stateless offloads for overlay network tunneling protocols

- Hardware offload of encapsulation and decapsulation of VXLAN, NVGRE, and GENEVE overlay networks

Management and Control

- NC-SI over MCTP over SMBus and NC-SI over MCTP over PCIe -Baseboard Management Controller interface

- PLDM for Monitor and Control DSP0248

- PLDM for Firmware Update DSP0267

- SDN management interface for managing the eSwitch

- I2C interface for device control and configuration

- General Purpose I/O pins

- SPI interface to Flash

- JTAG IEEE 1149.1 and IEEE 1149.6

Remote Boot

- Remote boot over Ethernet

- Remote boot over iSCSI

- Unified Extensible Firmware Interface (UEFI)

- Pre-execution Environment (PXE)

(*) 이 표시 에서는 하드웨어의 특징 및 기능에 대해 설명합니다. 기능 가용성은 드라이버 및 펌웨어 릴리스 정보를 참조하십시오.

Standards*

- IEEE 802.3cd, 50,100 and 200 Gigabit Ethernet

- IEEE 802.3bj, 802.3bm 100 Gigabit Ethernet

- IEEE 802.3by, Ethernet Consortium 25, 50 Gigabit Ethernet supporting all FEC modes

- IEEE 802.3ba 40 Gigabit Ethernet

- IEEE 802.3ae 10 Gigabit Ethernet

- IEEE 802.3az Energy Efficient Ethernet (supports only “Fast-Wake” mode)

- IEEE 802.3ap based auto-negotiation and KR startup

- IEEE 802.3ad, 802.1AX Link Aggregation

- IEEE 802.1Q, 802.1P VLAN tags and priority

- IEEE 802.1Qau (QCN) Congestion Notification

- IEEE 802.1Qaz (ETS)

- IEEE 802.1Qbb (PFC)

- IEEE 802.1Qbg

- IEEE 1588v2

- 25G/50G Ethernet Consortium “Low Latency FEC” for 50/100/200GE PAM4 links

- PCI Express Gen 3.0 and 4.0

(*) 이 표시 에서는 하드웨어의 특징 및 기능에 대해 설명합니다. 기능 가용성은 드라이버 및 펌웨어 릴리스 정보를 참조하십시오.

Adapter Card Portfolio & Ordering Information*

| Max. Network Speed |

Interface Type |

Supported Ethernet Speed [GbE] |

Host Interface [PCIe] |

Additional Features |

OPN |

|---|---|---|---|---|---|

| 2x 25GbE | SFP28 | 25 / 10 / 1 | PCIe 3.0 x8 | MCX512A-ACAT | |

| PCIe 3.0 x8 | UEFI Enabled (x86/Arm) | MCX512A-ACUT | |||

| Gen 4.0 x8 | ConnectX-5 Ex | MCX512A-ADAT | |||

| PCIe 3.0 x16 | MCX512F-ACAT | ||||

| PCIe 3.0 x16 | Enhanced Host Management | MCX512F-ACHT | |||

| 2x 40GbE | QSFP28 | 40 / 25 / 10 / 1 | PCIe 4.0 x16 | ConnectX-5 Ex | MCX516A-BDAT |

| 1x 50GbE | 50 / 40 / 25 / 10 / 1 | PCIe 3.0 x16 | MCX515A-GCAT | ||

| 2x 50GbE | PCIe 3.0 x16 | MCX516A-GCAT | |||

| 1x 100GbE | 100 / 50 / 40 / 25 / 10 / 1 | PCIe 3.0 x16 | MCX515A-CCAT | ||

| PCIe 3.0 x16 | UEFI Enabled (x86/Arm) | MCX515A-CCUT | |||

| 2x 100GbE | 100 / 50 / 40 / 25 / 10 / 1 | PCIe 3.0 x16 | MCX516A-CCAT | ||

| PCIe 3.0 x16 | Enhanced Host Management | MCX516A-CCHT | |||

| PCIe 4.0 x16 | ConnectX-5 Ex | MCX516A-CDAT |

1. All tall-bracket adapters are shipped with the tall bracket mounted and a short bracket as an accessory.

2. For Mellanox Socket-Direct models, refer to the ConnectX-5 VPI Mellanox Socket Direct Product Brief.