차세대 워크 로드를 위한 가속 컴퓨팅 플랫폼

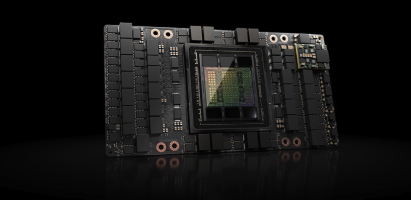

NVIDIA Hopper Architecture GPU

NVIDIA Hopper™ 아키텍처를 통해 가속화 컴퓨팅의 다음 단계, 엄청난 도약에 대해 알아보세요. Hopper는 소규모 기업부터 엑사스케일 고성능 컴퓨팅(HPC) 및 1조 개의 매개변수를 가진 AI에 이르기까지 모든 데이터 센터에서 다양한 워크로드를 안전하게 확장합니다. 이를 통해 뛰어난 혁신가들은 인류 역사상 가장 빠른 속도로 자신의 과제를 완수할 수 있습니다.

-

극대화된 딥 러닝 시스템이

비즈니스에 가져오는 혁신적인 성과최근 들어 전 세계적으로 각종 연구 및 개발팀이 NVIDIA GPU를 통해 AI와 딥 러닝을 활용하게 되며 질병 예방, 스마트 시티 건설, 분석 분야의 혁명 등의 다양한 분야에서 혁신적인 프로젝트를 실현해내고 있습니다.

-

오늘 날 HPC 데이터 센터의 엔진 NVIDIA Datacenter GPU

전 세계 상위 15개 HPC 애플리케이션 중 15개 애플리케이션과 모든 주요 딥 러닝 프레임워크를 포함하여 광범위한 도메인에서 700개 이상의 HPC 애플리케이션이 GPU에 최적화되어 있습니다.

-

NVIDIA Datacenter GPU의 가속화된 데이터 사이언스 솔루션

데이터 사이언스와 머신 러닝 워크플로우는 며칠이 걸리던 일을 불과 수 분으로 NVIDIA GPU와 함께 엔드투엔드로 가속화할 수 있습니다. NVIDIA의 가속화된 데이터 사이언스 솔루션에 대해 자세히 확인해보세요.

-

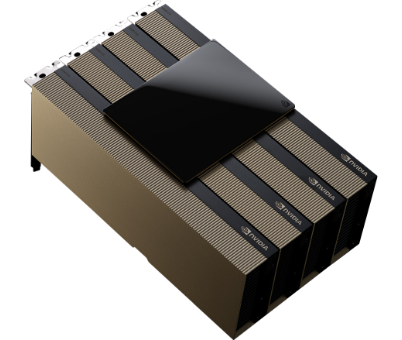

NVIDIA H200™ NVL 141GB엔비디아코리아 정품

NVIDIA H200™ NVL 141GB엔비디아코리아 정품NVIDIA H200 NVL은 데이터센터 내에 공간 제약이 있는 고객에게 이상적인 선택이며 규모에 상관없이 모든 AI 및 HPC 워크로드를 가속화합니다. 이전 세대에 비해 메모리가 1.5배, 대역폭이 1.2배 증가하여 고객은 몇 시간 이내에 LLM을 미세 조정할 수 있으며 LLM 추론을 1.8배 더 빠르게 경험할 수 있습니다.

자세히 보기 -

NVIDIA H100™ NVL 94GB 엔비디아코리아 정품

NVIDIA H100™ NVL 94GB 엔비디아코리아 정품최대 1,750억 개의 파라미터를 추론하는 LLM의 경우, NV링크 브리지가 있는 PCIe 기반 H100 NVL은 Transformer 엔진, NV링크 및 188GB HBM3 메모리를 활용하여 모든 데이터센터에서 최적의 성능과 간편한 확장을 제공함으로써 LLM을 메인스트림으로 가져옵니다. H100 NVL GPU가 탑재된 서버는 전력 제약이 있는 데이터센터 환경에서 낮은 레이턴시를 유지하면서 NVIDIA DGX™ A100 시스템보다 GPT-175B 모델 성능을 최대 12배까지 향상시킵니다.

자세히 보기

차세대 워크 로드를 위한 가속 컴퓨팅 플랫폼

NVIDIA Hopper 아키텍처

NVIDIA Hopper™ 아키텍처를 통해 가속화 컴퓨팅의 다음 단계, 엄청난 도약에 대해 알아보세요. Hopper는 소규모 기업부터 엑사스케일 고성능 컴퓨팅(HPC) 및 1조 개의 매개변수를 가진 AI에 이르기까지 모든 데이터 센터에서 다양한 워크로드를 안전하게 확장합니다. 이를 통해 뛰어난 혁신가들은 인류 역사상 가장 빠른 속도로 자신의 과제를 완수할 수 있습니다.

-

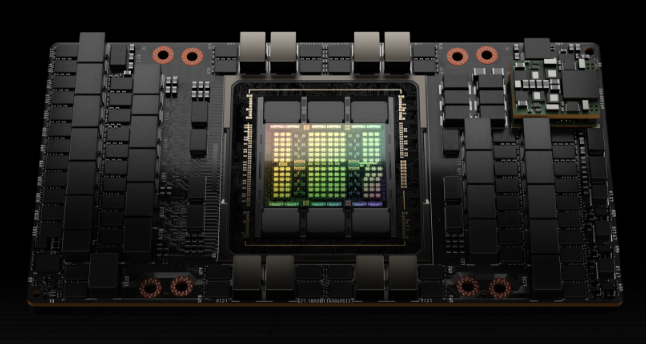

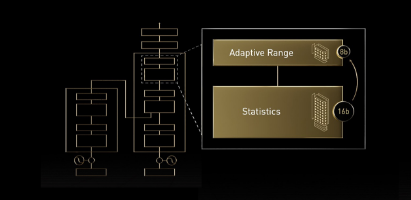

트랜스포머 엔진

트랜스포머 엔진NVIDIA Hopper 아키텍처는 AI 모델의 훈련을 가속하도록 설계된 트랜스포머 엔진을 통해 Tensor 코어 기술을 발전시킵니다. Hopper Tensor 코어는 FP8과 FP16 정밀도를 혼합 적용하여 트랜스포머의 AI 계산을 획기적으로 가속할 수 있습니다. 또한 Hopper에서는 TF32, FP64, FP16, INT8 정밀도의 부동 소수점 연산(FLOPS)을 이전 세대의 3배로 늘렸습니다.

-

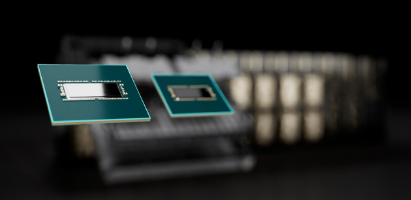

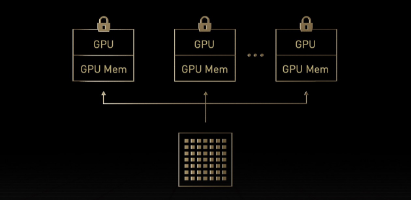

NVLink, NVSwitch 및 NVLink 스위치 시스템

NVLink, NVSwitch 및 NVLink 스위치 시스템4세대 NVLink는 NVIDIA DGX™ 및 HGX™ 서버를 통해 멀티 GPU 입력 및 출력(IO)을 PCIe Gen5 대역폭의 7배 이상인 GPU당 양방향 900GB/s 속도로 확장할 수 있습니다. 3세대 NVIDIA NVSwitch™는 이전에 Infiniband에서만 사용할 수 있었던 SHARP™ 인-네트워크 컴퓨팅을 지원하며, 이전 세대에 비해 8개의 H200 또는 H100 GPU 서버 내에서 2배 더 증가한 all-reduce 처리량을 제공합니다.

-

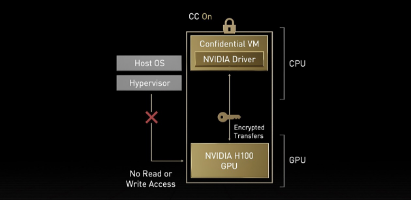

NVIDIA 컨피덴셜 컴퓨팅

NVIDIA 컨피덴셜 컴퓨팅데이터는 저장 공간에 저장되고 네트워크를 통해 전송되는 동안에는 암호화되지만, 처리되는 동안에는 보호되지 않습니다. NVIDIA 컨피덴셜 컴퓨팅은 사용 중인 데이터와 애플리케이션을 보호하여 이러한 격차를 해소합니다. 데이터와 애플리케이션의 기밀성과 무결성을 보호하는 동시에 AI 훈련, AI 추론, HPC 워크로드를 위한 H200 및 H100 GPU의 전례 없는 가속에 액세스할 수 있습니다.

-

2세대 MIG

2세대 MIGMIG(Multi-Instance GPU)를 사용하면 GPU를 자체 메모리, 캐시, 컴퓨팅 코어가 있는 더 작고 완전히 격리된 여러 인스턴스로 분할할 수 있습니다. Hopper 아키텍처는 최대 7개의 GPU 인스턴스에 걸쳐 가상화된 환경에서 멀티 테넌트 및 멀티 사용자 구성을 지원하여 MIG를 더욱 향상하고, 하드웨어 및 하이퍼바이저 수준에서 기밀 컴퓨팅으로 각 인스턴스를 안전하게 격리합니다.

-

DPX 명령

DPX 명령동적 프로그래밍은 복잡한 재귀 문제를 더 단순한 하위 문제로 세분화하여 해결하는 알고리즘 기술입니다. 나중에 다시 계산할 필요가 없도록 하위 문제의 결과를 저장함으로써 기하급수적인 문제 해결의 시간과 복잡성을 줄입니다. 동적 프로그래밍은 일반적으로 광범위한 사용 사례에서 사용됩니다. 예를 들어 플로이드-워셜은 운송 및 배송 차량의 최단 경로를 매핑하는 데 사용할 수 있는 경로 최적화 알고리즘입니다.

-

최첨단 TSMC 4N 프로세스

최첨단 TSMC 4N 프로세스최첨단 TSMC 4N 프로세스를 사용하여 800억 개 이상의 트랜지스터로 구축된 Hopper는 NVIDIA H200 및 H100 Tensor 코어 GPU를 지원하는 획기적인 5가지 혁신을 제공합니다. 이러한 혁신은 서로 결합하여 이전 세대보다 30배 빠른 놀라운 속도로 세계 최대의 생성형 언어 모델인 NVIDIA Megatron 530B 챗봇의 AI 추론을 제공합니다.

광범위한 산업 및 분야에서 획기적으로 향상된 HPC

사용자는 GPU 기반 병렬 프로세싱을 활용하여 고급의 대규모 애플리케이션 프로그램을 효율적이고 안정적이며 빠르게 실행할 수 있습니다. 또한 인-네트워크 컴퓨팅 및 고급 가속 엔진을 사용하는 NVIDIA InfiniBand 네트워킹은 확장 가능한 성능을 제공하여 복잡한 시뮬레이션을 보다 빠른 속도와 효율성으로 실행할 수 있도록 지원합니다.

-

슈퍼컴퓨팅

초신성 폭발 연구, 지구 내부 매핑, 허리케인 예측 등 연구자들이 세계 상황을 시뮬레이션하고 예측하는 데 필요한 역량을 제공합니다.

-

헬스케어 및 생명과학

신약 개발, 유전적 돌연변이 발견, 이미지 분석 등 의료 기관에 정밀 의학을 가속화하고 차세대 병원을 구축할 수 있는 첨단 도구를 제공합니다.

-

에너지

에너지 생산, 정유 및 유통, 환경에 미치는 영향 감소 등 에너지 혁신을 촉진하고 개인의 생활 방식을 향상함으로써 세계 경제에 영향을 미치고 있습니다.

-

공공 부문

사이버 보안, 재해 대응, 인도주의적 지원, NVIDIA는 커뮤니티의 안전성과 연결성을 더욱 높여 주는 기술을 구축하고 있습니다.

AI와 데이터 분석에서 고성능 컴퓨팅(HPC)과 렌더링까지

데이터센터는 가장 중요한 일부 문제를 해결하는 열쇠입니다

비교할 수 없는 양의 데이터를 생성하고 수집합니다. Generative AI를 배포하여 혁신적인 솔루션을 만드세요. AI 추론 프로세스를 가속화합니다. 애플리케이션을 강화하여 과학적 혁신을 주도하세요. 데이터 센터의 효율성과 뛰어난 성능을 활용하는 워크로드에 대한 통찰력을 얻으세요.

-

Data Science

Data Science매일 기업에서는 전례 없는 양의 데이터를 수집하고 있습니다. 이 엄청난 양의 정보는 GPU 가속 분석을 사용하지 않는 사람들에게는 놓칠 수 있는 기회입니다. 데이터가 많을수록 더 많은 것을 배울 수 있습니다. NVIDIA 데이터 센터 플랫폼을 통해 기업은 그 어느 때보다 빠르게 실행 가능한 통찰력을 창출할 수 있습니다.

-

Generative AI

Generative AI엔터프라이즈 애플리케이션에는 해당 도메인에 집중하고 비즈니스에 대한 지식을 갖추고 고부가가치 작업을 수행하는 데 필요한 기술을 갖추도록 맞춤화된 AI가 필요합니다. 이러한 모델은 비즈니스 기능 전반에 걸쳐 확장되어야 하며 비즈니스가 성장하고 발전함에 따라 학습해야 합니다. 생성 AI 모델은 조직의 인텔리전스를 코드화합니다.

-

AI Inference

AI Inference데이터 센터에서 추론 워크로드를 가속화하려면 사용 가능한 모든 컴퓨팅 리소스를 확장하고 활용할 수 있는 민첩하고 탄력적인 인프라가 필요합니다. 최신 NVIDIA 솔루션은 추론 워크로드를 가속화하여 AI를 애플리케이션에 적용하는 데 필요한 최고의 처리량과 실시간 응답성을 제공하는 독보적인 위치에 있습니다.

-

High Performance Computing

High Performance ComputingHPC는 데이터 센터의 과학 발전을 촉진하는 가장 필수적인 도구 중 하나입니다. 광범위한 도메인에 걸쳐 수천 개의 애플리케이션을 최적화하는 NVIDIA GPU는 현대 HPC 데이터 센터의 엔진입니다. NVIDIA 데이터 센터 플랫폼은 더 적은 수의 서버로 획기적인 성능을 제공하여 더 빠른 통찰력과 극적인 비용 절감을 제공함으로써 과학적 발견의 길을 열어줍니다.

-

Rendering

Rendering업계 전반의 디자이너와 아티스트는 그 어느 때보다 더 빠르게 고품질 콘텐츠를 제작해야 하지만, 비효율적인 CPU 기반 렌더링 솔루션으로 인해 생산성이 제한됩니다. NVIDIA RTX™ 서버는 값비싼 CPU 렌더팜의 한계를 뛰어넘습니다. NVIDIA 소프트웨어 및 주요 타사 소프트웨어로 구성할 수 있는 매우 유연한 참조 디자인으로 가장 복잡한 렌더링 작업 부하를 가속화합니다.

-

Virtualization

VirtualizationNVIDIA 가상 GPU 솔루션은 가상화된 최신 데이터센터를 지원함으로써 NVIDIA 가상 GPU(vGPU) 소프트웨어로 풍부한 그래픽의 확장 가능한 가상 데스크톱과 워크스테이션을 제공합니다. 이러한 솔루션은 가상 머신에서 AI, 딥 러닝, 데이터 사이언스, HPC 등의 컴퓨팅 집약적 서버 워크로드를 실행 가능하며, 개선된 관리 및 보안 기능이라는 이점도 활용합니다.

NVIDIA AI Enterprise 라이선스 활성화

NVIDIA AI Enterprise는 엔드 투 엔드 클라우드 네이티브 소프트웨어 플랫폼으로, 데이터 사이언스 파이프라인을 가속화하고 프로덕션급 검색 증강 생성(RAG), Co-Pilot 및 기타 엔터프라이즈 생성형 AI 애플리케이션의 개발 및 배포를 간소화합니다. 엔터프라이즈급 보안, 지원, 관리 용이성 및 안정성으로 최적화된 모델 성능을 제공하는 사용하기 쉬운 NIM 추론 마이크로서비스입니다.

자세히 보기