Cisco UCS C880A M8 Rack Server

시스코시스템즈 코리아 정품

- 10RU 19inch rack server(NVIDIA의 HGX 참조 아키텍처 기반)

- 2x Intel Xeon 6th Gen

- 8x Nvidia HGX B300 NVL8

- Boot Drive: 2x 960GB M.2 SATA SSD with RAID controller

- Internal Storage: Up to 8x PCIe Gen5 x4 E1.S NVMe SSD

- E-W Networking: 8x GPU-board integrated ConnectX-8

- N-S Networking: 2x CX-7 2x200G (crypto) or 2x B3220 2x200G (crypto) or

2x B3240 2x400G (crypto), 1x OCP TFF Gen5 x8

모듈식 서버 설계로 모든 데이터 센터에 가속 컴퓨팅을 도입하세요.

-

최신 프로세서 지원

Intel Xeon Scalable, AMD EPYC, NVIDIA Grace Hopper 등 최신 CPU 프로세서 지원

-

GPU 가속 컴퓨팅

NVIDIA Blackwell Architecture, Hopper Architecture 등 AI 및 딥러닝 최적화 GPU 솔루션

-

메모리 용량 및 속도

사용자의 애플리케이션의 메모리 요구사항에 맞춰 최적의 DDR5/DDR4 메모리 용량과 속도제안

-

고속 인터커넥트

스케일업 인프라를 위한 최고의 InfiniBand, RoCE, NVLink를 통한 초고속 네트워크로 데이터 전송 병목 현상 제거

-

고밀도 스토리지

NVMe, Intel Optane, SSD 등 최첨단 고성능 스토리지 솔루션 통합, 데이터 집약적인 작업에 압도적인 속도와 효율성 제공

Cisco UCS C880A M8 Rack Server

Cisco Unified Computing System (UCS)는 서버 하드웨어, 네트워킹, 가상화 지원 및 통합 관리 기능을 하나의 시스템으로 통합한 차세대 데이터센터 플랫폼입니다. 2009년에 시스코 시스템즈에 의해 처음 소개된 이래, UCS는 통합 패브릭(Unified Fabric)을 통해 LAN, SAN, 관리 네트워크를 단일 인프라로 단순화하고, UCS Manager나 Cisco Intersight를 활용한 중앙 집중식 관리를 통해 데이터센터 운영의 복잡성을 획기적으로 줄였습니다.

UCS는 B-시리즈(블레이드 서버), C-시리즈(랙 서버), 그리고 블레이드와 랙의 장점을 결합한 최신 X-시리즈(모듈형 시스템)를 포함하는 다양한 폼팩터를 제공하여 광범위한 워크로드 요구사항을 충족합니다. 특히, 최근에는 NVIDIA MGX 및 HGX와 같은 고성능 가속 컴퓨팅 아키텍처를 수용하는 플랫폼을 통해 인공지능(AI) 및 고성능 컴퓨팅(HPC)과 같은 GPU 집약적 워크로드에 최적화된 유연하고 효율적인 컴퓨팅 환경을 제공하며 데이터센터의 혁신을 주도하고 있습니다.

-

UCS X-시리즈 모듈형 시스템

하이브리드 클라우드 인프라의 운영 효율성, 민첩성, 확장성을 극대화하세요.

-

UCS B 시리즈 블레이드 서버

다양한 물리적 및 가상 워크로드에 대해 더 나은 성능과 운영 효율성을 활용하세요.

-

UCS C-시리즈 랙 서버

프로세서, 메모리, I/O, 내부 스토리지 리소스를 유연하게 조합하여 모든 작업 부하 과제를 해결하세요.

-

UCS S-시리즈 스토리지 서버

이 모듈식, 고가용성, 스토리지 최적화 서버를 통해 데이터와 통찰력을 실시간으로 활성화하세요.

신뢰할 수 있는 성능. 탁월한 효율성

6세대 Intel® Xeon® Processors

Intel Xeon 6 프로세서 제품군에는 현대 데이터센터의 끊임없이 변화하는 요구를 충족하기 위해 필수적인 성능과 효율성 모두를 갖춘 뛰어난 강력한 컴퓨팅 플랫폼이 존재합니다. 컴퓨팅 집약적 워크로드 지원부터 확장 가능한 클라우드 네이티브 마이크로서비스 구현까지, 이 프로세서 제품군은 다양한 운영 요구 사항에 맞는 다양한 기능을 제공합니다.

혁신적인 모듈형 x86 아키텍처를 기반으로 하는 Intel Xeon 6 프로세서 제품군은 데이터센터 설계자가 프라이빗, 퍼블릭 및 하이브리드 클라우드 전반에서 고유한 요구 사항과 워크로드에 맞춰 특별히 설계된 인프라를 구성하고 구축할 수 있도록 지원합니다. 이러한 다재다능함을 제공하기 위해 Intel Xeon 6 프로세서는 성능 코어(P-코어)와 효율 코어(E-코어)의 두 가지 CPU 마이크로아키텍처를 선택할 수 있도록 지원합니다.

-

P-코어 또는 E-코어 탑재

Xeon 6프로세서는 유연성을 위해 Performace-core(P-core)와 Efficient-core(E-core)의 두 가지 서로 다른 CPU 마이크로아키텍처를 제공하며, 고밀도 컴퓨팅 및 스케일아웃 워크로드부터 AI 가속 고성능 멀티코어 컴퓨팅에 이르기까지 광범위한 비즈니스 요구 사항을 충족하도록 설계된 다양한 프로세서 옵션이 있습니다.

-

리더십 AI 추론 성능

Xeon 6 프로세서는 다양한 워크로드에서 전반에서 더 많은 코어, 마이크로아키텍처 선택 옵션, 추가적인 메모리 대역폭 및 탁월한 입출력(I/O)을 통해 새로운 차원의 성능을 제공합니다. Multiplexed Rank DIMM(MRDIMM) 지원, Compute Express Link(CXL) 향상, 통합 가속기 등의 기능으로 대상 워크로드에 더욱 향상된 성능과 효율성을 제공합니다.

-

성능과 효율성의 조화

Xeon 6 프로세서는 4개 시리즈로 제공되며 이전 세대 대비 더 많은 코어 수, 더 큰 캐시, 더 빠르고 더 큰 용량의 메모리 및 향상된 I/O 옵션을 통해 엔트리 레벨 및 까다로운 워크로드를 처리할 수 있는 계층화된 기능을 제공합니다. 모든 인텔 제온 6 프로세서 제품군은 호환 가능한 x86 명령어 세트 아키텍처(ISA)와 CPU 소켓 유형을 포함한 공통 하드웨어 플랫폼을 사용합니다.

NVIDIA HGX™ Platform

NVIDIA HGX 플랫폼은 NVIDIA GPU, NVIDIA NVLink™, NVIDIA 네트워킹, 완벽하게 최적화된 AI 및 고성능 컴퓨팅(HPC) 소프트웨어 스택의 모든 기능을 하나로 모아 모든 데이터 센터에서 최고의 애플리케이션 성능을 제공하고 가장 빠른 시간 내에 통찰력을 확보할 수 있도록 지원합니다.

NVIDIA HGX B300은 8개의 NVIDIA Blackwell Ultra GPU를 고속 상호 연결로 통합하여 HGX B200 대비 1.5배 더 높은 FP4 Tensor Core FLOPS와 2배 더 높은 어텐션 성능을 제공하여 데이터 센터를 가속 컴퓨팅 및 생성적 AI의 새로운 시대로 이끌 것입니다. 이전 세대보다 최대 30배 더 많은 AI Factory 출력을 제공하는 최고의 가속 스케일업 플랫폼인 NVIDIA Blackwell Ultra 기반 HGX 시스템은 가장 까다로운 생성적 AI, 데이터 분석 및 HPC 워크로드를 위해 설계되었습니다.

DeepSeek-R1 ISL = 32K, OSL = 8K, FP4 Dynamo 분할 기능을 갖춘 HGX B300. FP8 인플라이트 배칭 기능을 갖춘 H100. 예상 성능은 변경될 수 있습니다.

AI 추론 성능 및 다용성 HGX B300 AI 공장 출력으로 수익 증대

프런티어 곡선은 AI 팩토리 토큰 수익 산출량을 결정하는 주요 매개변수를 보여줍니다. 세로축은 1메가와트(MW) AI 팩토리에서 초당 GPU 토큰 처리량(TPS)을 나타내고, 가로축은 단일 사용자에 대한 사용자 상호작용성과 반응성을 TPS로 정량화합니다. 처리량과 반응성이 최적의 교차점에서 HGX B300은 최대 토큰 수익을 위해 NVIDIA Hopper 아키텍처 대비 AI 팩토리 출력 성능을 전체적으로 30배 향상시킵니다.

예상 성능은 변경될 수 있습니다. GPU당 성능, FP8, 16K BS, 16K 시퀀스 길이 기준입니다.

대규모 AI 모델을 위한 확장 가능한 교육 차세대 교육 성과

HGX B300 플랫폼은 DeepSeek-R1과 같은 대규모 언어 모델에 대해 최대 2.6배 더 높은 학습 성능을 제공합니다. 2TB 이상의 고속 메모리와 14.4TB/s의 NVLink 스위치 대역폭을 통해 대규모 모델 학습과 고처리량 GPU 간 통신을 지원합니다.

NVIDIA 네트워킹을 통한 HGX 가속화

데이터 센터는 컴퓨팅의 새로운 단위이며, 네트워킹은 데이터 센터 전반의 애플리케이션 성능 확장에 필수적인 역할을 합니다. NVIDIA Quantum InfiniBand와 결합된 HGX는 세계 최고 수준의 성능과 효율성을 제공하여 컴퓨팅 리소스를 최대한 활용할 수 있도록 보장합니다. 이더넷을 구축하는 AI 클라우드 데이터 센터의 경우, HGX는 이더넷을 통해 최고의 AI 성능을 제공하는 NVIDIA Spectrum-X 네트워킹 플랫폼 과 함께 사용하는 것이 가장 좋습니다. 최적의 리소스 활용 및 성능 격리를 위해 Spectrum-X 스위치와 NVIDIA SuperNIC을 탑재하여 모든 규모에서 동시에 실행되는 수천 개의 AI 작업에 대해 일관되고 예측 가능한 결과를 제공합니다. Spectrum-X는 고급 클라우드 멀티 테넌시와 제로 트러스트 보안을 지원합니다. NVIDIA는 레퍼런스 설계로 NVIDIA HGX 8-GPU 플랫폼, BlueField-3 SuperNIC, 그리고 Spectrum-4 스위치 기반 Dell PowerEdge XE9680 서버로 구축된 하이퍼스케일 생성형 AI 슈퍼컴퓨터 Israel-1을 설계했습니다.

NVIDIA Spectrum-X 이더넷 스위치

NVIDIA Spectrum Ethernet SN5000 시리즈 스위치는 하이퍼스케일 생성형 AI 패브릭 가속화를 위해 특별히 설계된 5세대 Spectrum Ethernet 스위치입니다. 최대 800Gb/s(기가비트/초)의 포트 속도를 제공하는 SN5000 스위치는 성능과 기능 모두에서 타협하지 않고 모든 데이터 센터에 가속화된 이더넷을 제공합니다.

자세히 보기

NVIDIA Spectrum-X 이더넷 SuperNIC

하이퍼스케일 AI 워크로드를 가속화하기 위해 특별히 설계된 새로운 차원의 네트워크 가속기 NVIDIA Spectrum-X 이더넷 SuperNIC는 네트워크 집약적인 대규모 병렬 컴퓨팅을 위해 설계되어 GPU 서버 간에 최대 800Gb/s의 RDMA over Converged Ethernet(RoCE) 네트워크 연결을 제공하여 AI 워크로드의 최대 효율성을 최적화합니다.

자세히 보기Cisco UCS C880A M8 Rack Server

NVIDIA HGX Platform을 기반으로 하는 Cisco UCS C880A M8 랙 서버는 가장 까다로운 인공지능(AI) 및

고성능 컴퓨팅(HPC) 워크로드를 처리하도록 설계된 고밀도 공랭식 랙 서버입니다.

HGX 플랫폼과 8개의 NVIDIA HGX B300(SXM) GPU를 통합하고 Intel® Xeon® 6세대 프로세서 2개를 탑재하여

실시간 LLM (대규모 언어 모델) 추론, 차세대 학습 성능 및 대용량 데이터 처리에 이상적입니다.

C880A M8은 대규모 모델 학습 및 미세 조정부터 실시간 추론 및 대용량 데이터 처리에 이르기까지 전체 AI 스택에서 고객을 지원하며, Cisco의 AI 전략에 완벽하게 통합되어 강력한 컴퓨팅 인프라를 제공함으로써 AI 시대를 연결하고 보호합니다.

이 서버는 Cisco UCS® 고밀도 AI 서버 포트폴리오를 확장하여 서비스 제공업체, 금융 서비스, 제조, 의료, 생명 과학, 자동차 등 다양한 산업 분야의 기업에 강력한 솔루션을 제공합니다. 고급 아키텍처를 기반으로 탁월한 성능, 확장성 및 엔터프라이즈 관리 용이성을 보장하여 대규모 AI 모델 학습, 미세 조정, 추론과 같은 컴퓨팅 집약적인 AI 사용 사례에 이상적입니다.

AI 잠재력 발휘를 위한 궁국의 도구

Cisco UCS C880A M8 랙 서버는 최첨단 NVIDIA HGX 플랫폼과 8개의 NVIDIA B300(SXM) GPU를 통합하여 차별화된 성능을 제공합니다. 이 강력한 GPU 구성은 대규모 AI 모델 학습, 미세 조정, 실시간 추론 등 가장 까다로운 AI 워크로드에 차세대 성능을 제공하는 핵심 요소입니다. B300 GPU는 복잡한 딥 러닝 모델과 대규모 언어 모델 가속화에 필수적인 엄청난 병렬 처리 성능과 고속 GPU 상호 연결을 제공합니다. 이러한 통합을 통해 기업은 토큰 처리량을 높이고 AI 운영의 경제성을 개선하여 LLM 및 에이전트 워크로드를 수익성 있게 확장할 수 있습니다.

포괄적인 엔터프라이즈 AI 관리

Cisco UCS C880A M8 랙 서버는 엔터프라이즈 환경에 적합하도록 설계되었습니다. C880A M8에서는 Cisco Intersight를 통한 쉬운 관리를 목표로합니다. Cisco Intersight는 서버 수명 주기 관리를 간소화하는 클라우드 기반 관리 플랫폼을 제공하며, 전력 운영, 광범위한 모니터링 지표, 서버 구성 관리, 펌웨어 번들 릴리스 관리 등의 기능을 제공합니다. 이러한 중앙 집중식 제어 및 가시성을 통해 AI 인프라 운영을 간소화하고 복잡성을 줄이며 데이터 센터 전체에서 일관된 정책 시행을 보장합니다.

AI 및 HPC 워크로드를 위한 설계

Cisco UCS C880A M8 랙 서버는 강력한 성능 외에도 AI 및 HPC의 고유한 요구 사항을 충족하도록 특별히 설계되었습니다. 실시간 대용량 언어 모델 추론을 지원하여 AI 기반 애플리케이션의 신속한 배포와 응답성을 구현합니다. 또한, 차세대 학습 성능도 뛰어나 복잡한 AI 모델 학습에 필요한 시간을 크게 단축합니다. 대용량 데이터 처리 용량 덕분에 GPU 가속 ETL(Extracted Logging) 프로세스를 포함한 데이터 과학 및 빅데이터 분석에 이상적인 플랫폼입니다. 이러한 특화된 설계를 통해 기업은 AI 모델을 효율적으로 구축, 최적화 및 활용하여 확장 가능한 고성능 솔루션으로 비즈니스 성장을 가속화할 수 있습니다.

Cisco Intersight 지원

Cisco UCS C880A M8은 AI 및 HPC 워크로드를 호스팅하고 가속화하도록 설계된 전용 랙 서버 플랫폼입니다. 데이터센터 환경에서 AI/HPC 구축에 일반적으로 사용되는 다양한 운영 체제와 가상화 플랫폼을 지원합니다. 특정 소프트웨어 스택 호환성에는 AI 애플리케이션 구축 및 최적화를 위한 NVIDIA AI Enterprise 및 NVIDIA NIM(NVIDIA Inference Microservices)이 포함됩니다.

Cisco UCS C880A M8 기능 및 이점

-

8개의 NVIDIA B300(SXM) GPU가 탑재된 NVIDIA HGX

NVIDIA의 주력 슈퍼컴퓨팅 GPU를 활용하여 AI 모델 학습, 미세 조정 및 추론을 가속화하는 데 중요한 탁월한 처리 능력을 제공합니다.

-

Intel Xeon 6 세대 프로세서 2개

병목 현상 없이 교육 및 추론 파이프라인에 데이터를 공급하는 데 이상적인 GPU 가속을 보완하도록 최적화된 고주파, 고처리량 CPU를 탑재했습니다.

-

보드 통합 NVIDIA ConnectX-8 NIC(E/W 트래픽)

내장된 동서 800G 네트워킹 패브릭은 확장 가능한 AI 교육을 위해 초저 지연 시간, 고대역폭 GPU 간 및 서버 간 통신을 제공합니다.

-

최대 8개의 E1.S NVMe SSD

고성능 로컬 NVMe 스토리지는 AI 모델 학습을 위한 초저지연 데이터 개싱과 빠른 체크포인팅을 제공합니다.

-

핫스왑 가능한 중복 전원 공급 장치

가동 중지 시간을 최소화하고 가용성을 극대화하도록 설계된 중복되고 쉽게 서비스할 수 있는 전원 공급 장치를 통해 엔터프라이즈급 복원력을 제공합니다.

-

실시간 대규모 언어 모델(LLM) 추론

LLM의 빠르고 효율적인 배포를 가능하게 하여 즉각적인 대응이 필요한 실시간 애플리케이션 및 서비스를 지원합니다.

-

차원이 다른 훈련 성과

대규모 복합한 AI 모델을 훈련하는 데 필요한 시간을 크게 줄여 반복 및 개발 주기를 더욱 빠르게 할 수 있습니다.

-

대용량 데이터 처리

대용량 데이터 세트를 처리하도록 설계되어 가속화된 추출, 변환 및 로드(ETL) 프로세스와 GPU 가속 빅데이터 분석을 용이하게 합니다.

-

AI를 위한 검증된 솔루션

컴퓨팅, 네트워킹, 스토리지, 소프트웨어를 포함하는 검증된 시스템 솔루션을 제공하고 AI 워크로드에 대한 안정적이고 최적화된 성능 제공하기 위한 Cisco의 해결사입니다.

-

확장 가능한 인프라

고밀도 GPU 플랫폼에 최적화되어 AI 워크로드 전반에 걸쳐 예측 가능한 성능을 제공하고 Cisco AI POD 내에서 유연한 확장을 허용하여 증가하는 AI 수요를 수용합니다.

Platform Full Stack Provider인 리더스시스템즈는 CISCO의 공인 파트너로서,

NVIDIA MGX/HGX 아키텍처 기반의 AI 서버 및 인프라 구축을 위한 전문 솔루션을 제공합니다.

회사소개 바로가기

-

Cisco partner

Cisco partner리더스시스템즈는 Cisco의 강력한 파트너십을 바탕으로 혁신적인 기술과 솔루션에 대한 최신 전문 지식과 공인된 역량을 갖추었으며, MGX/HGX 기반 Cisco 랙 서버를 통해 고객들이 AI 인프라 구축에 소요되는 시간과 비용을 절감하고 최적의 성능을 확보할 수 있도록 통합적인 풀스택 솔루션을 제공합니다.

-

NVIDIA Partner Network 인증 파트너

NVIDIA Partner Network 인증 파트너NVIDIA Elite Partner인 리더스시스템즈는 복잡한 글로벌 공급망 환경 속에서도 확실하고 안정적인 GPU 공급 능력을 보장합니다. 최고 등급 파트너십을 통해 최신 GPU를 가장 빠르고 안정적으로 확보하고, 이를 기반으로 고객의 AI 및 딥러닝 인프라 구축에 중단 없는 안정적인 솔루션을 제공합니다.

-

MGX/HGX 구축 및 유지를 위한 기술 지원

MGX/HGX 구축 및 유지를 위한 기술 지원리더스시스템즈의 AI 전문가가 랙 서버 구축을 위한 OS 설치 및 사전 테스트 등을 지원하며, 그 이후에도 모니터링, 정기 점검, 운영 교육을 지원하며, 이슈 발생 시 신속한 대응으로 다운타임을 최소화합니다. 또한 자원 활용 효율을 높여 전력 및 유지 비용 절 감과 데이터센터 TCO 최적화를 실현합니다.

-

TCO 절감을 위한 고효율 솔루션

TCO 절감을 위한 고효율 솔루션리더스시스템즈는 단순한 하드웨어 공급을 넘어, AI 인프라의 운영 안정성과 효율성을 책임집니다. 최신 고효율 액체 냉각 솔루션을 통해 GPU의 성능을 극대화하며, 무정전 전원 공급 장치(UPS)를 통합 설계하여 데이터센터의 전력 불안정 위험을 원천 차단하여 TCO 절감효과를 가져옵니다.

안전하게 미래 대비를 위한 AI 인프라를 구축할 수 있도록 지원합니다.

-

NVIDIA Blackwell 아키텍처 GPU

NVIDIA Blackwell 아키텍처 GPUNVIDIA Blackwell 아키텍처는 AI 워크로드에 강력한 가속 기능을 제공하여 에이전트 AI를 위한 데이터 처리 파이프라인을 최적화합니다. 예를 들어 파이프라인 대규모 AI 모델에 고성능 컴퓨팅을 제공하여 수집, 검색 및 처리 워크플로를 향상시킵니다.

자세히 보기 -

NVIDIA BlueField-3 DPU

NVIDIA BlueField-3 DPUNVIDIA BlueField-3 DPU는 가속된 네트워킹, 데이터 액세스 및 사이버 보안을 함께 제공하고, AI 네트워킹 및 엔터프라이즈 AI 팩토리를 구현합니다. 컴퓨팅, 스토리지 및 듀얼 포트 네트워킹을 통해 대규모 데이터 이동, 보안 및 관리를 위한 고성능 기반을 제공합니다. AI 네트워크의 성능 요구에 맞춰 확장 가능한 효율적인 인프라를 구축합니다.

자세히 보기 -

NVIDIA Spectrum-X 네트워킹 플랫폼

NVIDIA Spectrum-X 네트워킹 플랫폼NVIDIA Spectrum SN5000 시리즈 스위치와 Spectrum 이더넷 스위치로, 하이퍼스케일 생성형 AI 워크로드를 가속화하기 위해 특별히 설계되었습니다. SN5000 스위치는 초당 최대 800기가비트(Gb/s)에 도달하는 포트 속도를 통해 모든 데이터 센터를 위한 AI 네트워크를 제공합니다.

자세히 보기 -

NVIDIA ConnectX-8 SuperNIC PCIe 스위치

NVIDIA ConnectX-8 SuperNIC PCIe 스위치NVIDIA ConnectX-8 SuperNIC PCIe 스위치는 초고속 네트워킹과 4세대 PCIe Gen6 스위치를 결합한 여러 개의 SuperNIC을 통합해 도와줍니다. 이 보드는 개별 PCIe 스위치를 제거하고, 고가 대역폭을 두 배로 늘리고, 보드 설계를 간소화하며, 탁월한 확장성으로 차세대 BOD(보드 온 디바이스) 설계를 구현하여 RTX 프로 서버 아키텍처를 더욱 발전시킵니다.

자세히 보기 -

NVIDIA AI Enterprise

NVIDIA AI EnterpriseNVIDIA AI Enterprise는 NVIDIA NIM 및 NeMo 마이크로서비스를 포함한 소프트웨어 도구, 라이브러리 및 프레임워크로 구성된 클라우드 네이티브 AI 플랫폼입니다. 학습, 배포, 확장 과정을 간소화하고, 엔터프라이즈급 보안과 관리 기능을 제공하여 환경 간 이동, 데이터센터, 퍼블릭 클라우드 등 모든 곳에서 일관된 AI 시스템을 배포할 수 있습니다.

자세히 보기 -

NVIDIA vGPU로 가상 작업 공간 가속화

NVIDIA vGPU로 가상 작업 공간 가속화NVIDIA 가상 GPU(vGPU) 소프트웨어는 강력한 GPU 성능을 제공하여 그래픽이 풍부한 작업 워크스테이션에서 AI 개발에 이르기까지 다양한 가상 워크로드를 지원하며, IT 부서가 가상화된 업무 및 문맥이 항상 최신 워크로드에 필요한 NVIDIA GPU 성능을 활용할 수 있도록 지원합니다.

자세히 보기

리더스시스템즈를 통해 신속한 기술 지원과 장비 서비스를 받아보세요.

즉각적인 장애 처리 서비스를 보장합니다.

리더스시스템즈는 전문 엔지니어를 보유하여 장애 발생 시 원활한 대응이 가능하며 전화를 통한 문의 응대부터

전문 엔지니어 방문까지 단계적 지원을 하고 있습니다.

또한 지속적으로 정기점검, 교육, H/W 및 S/W 업데이트, 패치 지원 등 사후관리를 통해 고객만족을 약속합니다.

-

AI 서버 구축 서비스

일정에 따른 안정적인 제품 공급, 전문적인 인프라 설계를 통한 시스템 구축

-

서버 운영 및 관리 전화 지원 서비스

시스템 운영 중에 있을 수 있는 긴급문의 사항을 문의하여 즉각적으로 문제 해결 도움

-

서버 분석 서비스

HW 및 솔루션 관련 문제 및 장애 발생 시 리더스시스템즈에서 Escalation 지원

-

사전점검 서비스

사전 안내 후, 정기점검을 통한 사후발행 문제 관련 원천차단을 통한 안전성 확보

-

서버 OS 및 하드웨어 관리 전담지원 서비스

리더스시스템즈 전담 기술 Support 담당자를 통한 S/W & H/W 장애, 재설치, 교육, 정기 점검 수행

-

프리미엄 급 서비스

변경작업 On-site 작업 계획서, 정기점검 각종 산출물 제공, HW 펌웨어, SW 업데이트, 패치 지원 재설치 On-site 지원

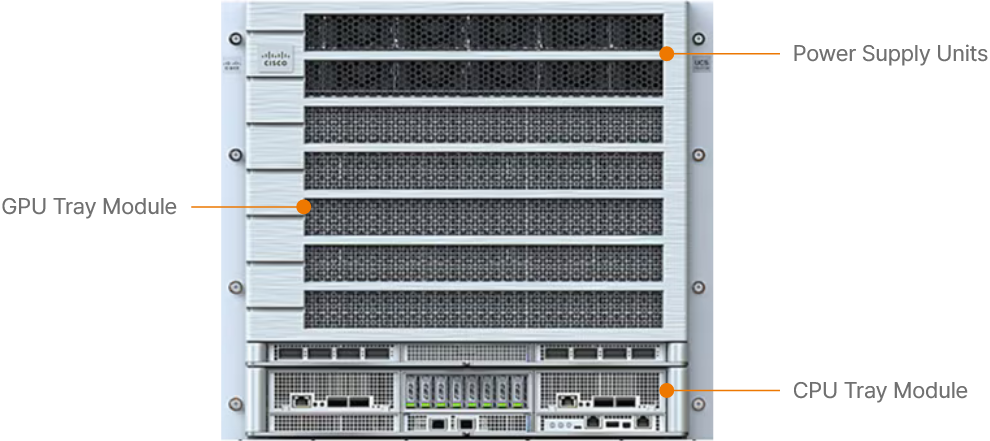

UCS C880A M8 앞면

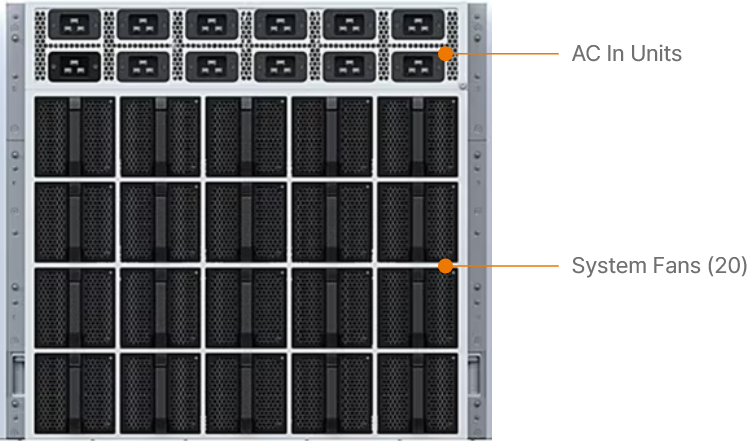

UCS C880A M8 뒷면

Specifications

| Form factor | 10RU 19inch rack server (based on NVIDIA’s HGX reference architecture) |

|---|---|

| Processor |

|

| Memory |

|

| GPUs | 8× Nvidia HGX B300 NVL8 |

| Boot drives | 2x 960GB M.2 SATA SSD with RAID controller |

| Internal storage | Up to 8x PCIe Gen5 x4 E1.S NVMe SSD |

| E-W Networking | 8× GPU-board integrated ConnectX-8 |

| N-S Networking |

|

| Power supply | 12× 80PLUS 54V 3.2kW MCRPS hot-swappable redundant PSUs (N+N) |

| Management | Cisco BMC |

| Hardware and Software Interoperability |

See the Cisco Hardware and Software Interoperability List for a complete listing of supported operating systems and peripheral options |

| System Cooling | 20× Hot-swappable (N+1) For System Cooling |

| Front IO | 2 USB 2.0, 1 ID Button, 1 Power Button |

| Rear IO |

1 USB 3.0 A,1mDP, 1 ID Button, 1 Power Button,

1 USB 2.0 A UART (for debugging), 1 RJ45 (mgmt.), 1 System ID LED/button |

| Power | 12× 54V 3200W (N+N) PSUs |

| System Power Consumption | Up to 14.3KW |

| Dimensions | 441×447×800 (mm) |

Ordering information

| UCSC-880A-M8-B301 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 96GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA ConnectX-7 (2x200G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

|---|---|

| UCSC-880A-M8-B302 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 96GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA B3220 (2x200G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

| UCSC-880A-M8-B303 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 128GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA ConnectX-7 (2x200G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

| UCSC-880A-M8-B304 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 128GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA B3220 (2x200G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

| UCSC-880A-M8-B305 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 96GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA B3240 (2x400G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

| UCSC-880A-M8-B306 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 128GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA B3240 (2x400G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

| UCSC-880A-M8-B307 | 2x Intel Xeon 6776P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 64GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA ConnectX-7 (2x200G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

| UCSC-880A-M8-B308 | 2x Intel Xeon 6767P 2.3 GHz (Max Turbo 3.9 GHz) CPUs, 8x NVIDIA HGX B300 SXM GPUs, 32x 96GB up to 4000 MT/s DIMMs, 2x 960GB M.2 SATA Boot Drive, 2x E1.S 3.84TB NVMe SSD Data Drives, 8x NVIDIA ConnectX-8 (GPU board integrated) for East/West N/W, 2x NVIDIA ConnectX-7 (2x200G) crypto-enabled for North/South N/W, 1x Intel X710-T2L OCP |

Information

| 상품명 | Cisco UCS C880A M8 |

|---|---|

| KC 인증번호 | - |

| 출시년월 | - |

| 제조자 | Cisco |

| 제조국 | - |

| 크기 | 441×447×800 (mm) |

| 정품 품질 보증 | 3년 무상보증 |