에이전틱 AI를 위한 빌딩 블록

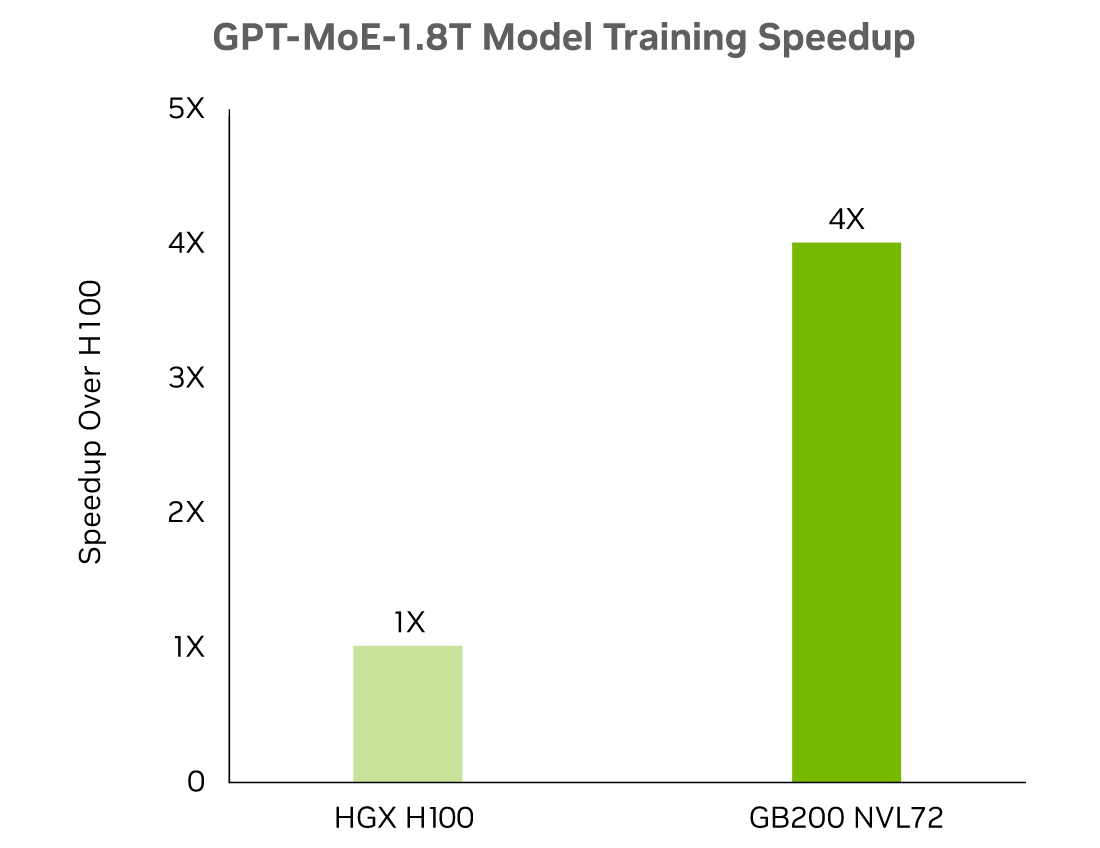

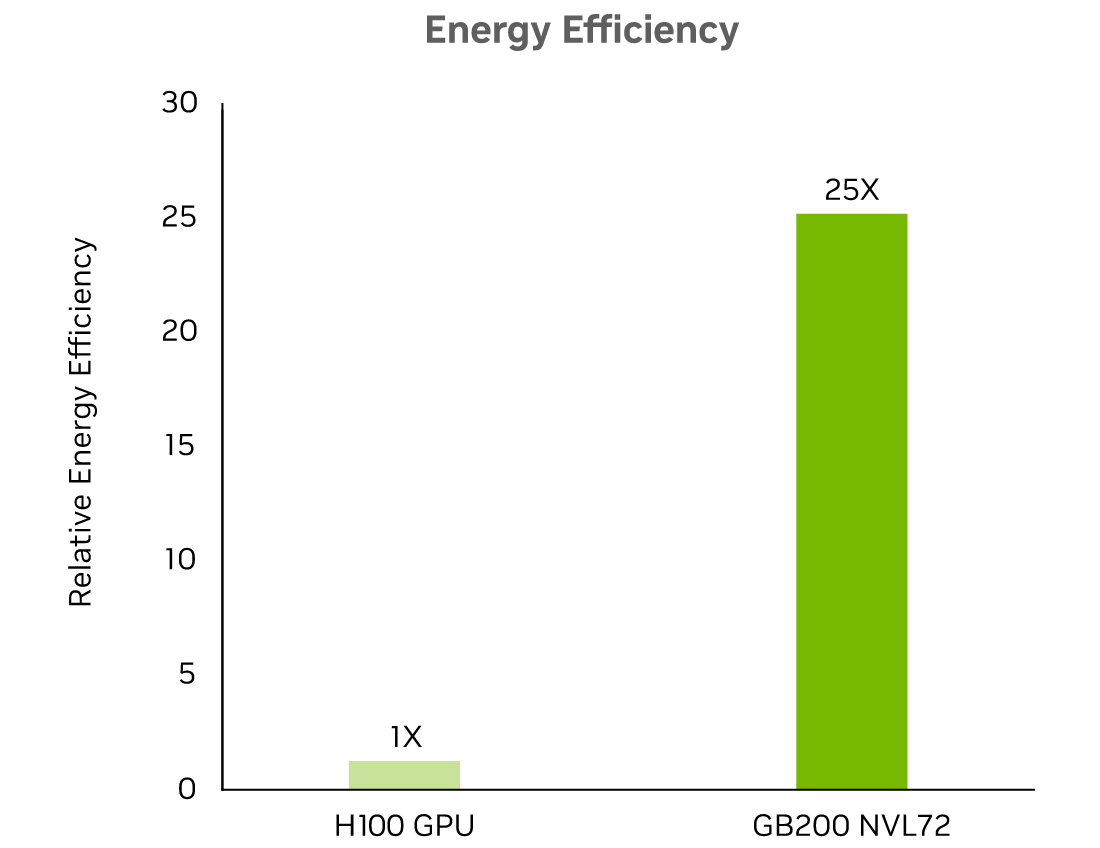

딥 러닝 신경망이 더욱 복잡 해짐에 따라 훈련 시간이 크게 증가하여 생산성이 낮아지고 비용이 높아집니다. NVIDIA의 딥 러닝 기술과 완전한 솔루션 스택은 AI 교육을 크게 가속화하여 더 짧은 시간에 더 깊은 통찰력을 얻고 상당한 비용을 절감하며 ROI 달성 시간을 단축합니다. 최신 추론 및 생성 AI 모델 에 최적화된 추론 성능을 확보하세요. NIM에는 NVIDIA® TensorRT™ , TensorRT-LLM 등 NVIDIA 및 커뮤니티에서 제공하는 가속 추론 엔진이 함께 제공되며, NVIDIA 가속 인프라에서 저지연, 고처리량 추론을 위해 사전 구축 및 최적화되었습니다.